Избранное трейдера Роман Давыдов

Десятки роботов дарю! )

- 29 октября 2021, 10:13

- |

Легко и весело дарить чужое… ;-)

Друзья, есть предложение раз в неделю или около того писать что-нибудь прагматичное и практичное, что можно использовать в реальной жизни. Многие интересуются, какие конкретно кнопки нужно нажимать, чтобы стать ближе к торговым роботам.

Давайте возьмем какого-нибудь простого смертного человека и посмотрим, с какими трудностями он будет сталкиваться и как с этими трудностями будет справляться, какие открытия на своем пути будет делать и куда его любопытство заведет.

Пусть этого человека зовут, например, Вася. И пусть этот Вася будет блондином. Эм… Нет, какой-то неправильный сюжет. Пусть это будет девушка Маша. И вот Маша-то как раз и была блондинкой брюнеткой рыженькой самой обычной девушкой, которая вообще не умела программировать, но очень об этом мечтала всю свою жизнь. В общем, Маше твердо пообещали, что, может, как-нибудь даже и без программирования обойдется. Соврали, наверно.

( Читать дальше )

- комментировать

- 4.1К | ★37

- Комментарии ( 16 )

Как самому предсказать дефолт без знаний за 5 минут-2.0

- 14 октября 2021, 15:01

- |

Работает для ВДО и АКЦИЙ!

Имея знания и опыт, можно рассчитать инвестиционный риск, и понять финансовое состояние предприятия. Также можно попытаться понять когда конторе придёт дефолт. Расчёты займут много времени и усилий, даже при поверхностном анализе. Поэтому, для оценки финансового состояния предприятия и в знак благодарности подписчикам, я написал бесплатную программу ЛИСП-ИР. Кто ещё не знаком с «предсказателем» дефолтов, прочитайте эту статью.

Оценка инвестиционного риска с помощью «ЛИСП-ИР»

Здравствуйте, юные инвесторы, начинающие и продвинутые. Для своих подписчиков, которые уже успели оценить преимущества «предсказателя» дефолтов ЛИСП-ИР, спешу сообщить, что я усовершенствовал программу и она теперь более придирчиво и более правильно относится к предприятиям, у которых много долгов.

( Читать дальше )

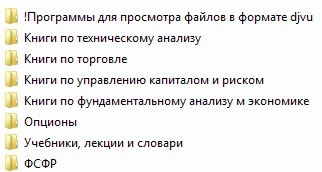

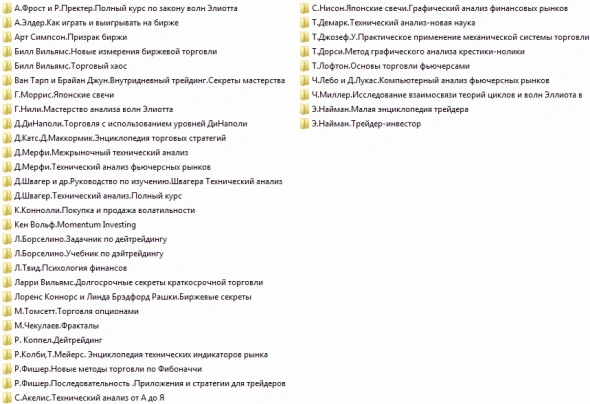

Раздаю КАЧАЙТЕ!!! Более 300 книг по трейдингу.

- 11 октября 2021, 13:19

- |

Берите больше.

Выкладывал данный материал пару лет назад. Да не новое, а что поменялось? Да все тоже самое, свечи по другому выглядеть не стали.

Сейчас убрал лишний мусор. Да и народу с того времени прибавилось достаточно на сайте так что думаю многим будет актуально.

Сейчас же все инвесторы. На пенсию в 35. 25млн счетов уже.

Читать не перечитать.

Читайте просвещайтесь. Может и найдете грааль между строк.

Базовые знания тоже самое что и на курсах но только за деньги))))

Так же материал по опционам если вы до сих пор сливаете на них прочитав может перестанете.

Но это не точно)))

( Читать дальше )

Как быстро оценить свой портфель

- 07 октября 2021, 22:35

- |

Привет всем. Чтобы не изобретать велосипеды #софты для просмотра структуры портфеля#.

Скачиваем R, RStduio. В RStudio устанавливаем библиотеки: rusquant, PerformanceAnalytics, PerformanceAnalytics.

Добавляем следующий код в RStudio.

Подключаем библиотеки:

library(rusquant) library(PerformanceAnalytics) library(PortfolioAnalytics)

Задаем тикеры, веса, начальную дату и просто переменную куда вытянем цены.

tickers <- c("FXGD","IRAO")

weights <- c(.5,.5)

start_data <- "2014-01-01"

PortPrices <- NULLВытягиваем данные с финама, есть и другие источники mfd,alor(вроде)

for(curr in tickers) {

PortPrices <- cbind(PortPrices, getSymbols(curr, src = 'Finam', auto.assign = FALSE)[,4])

}Тянем значения индекса, очищаем от пропущенных значения, считаем дневную доходность.

benchmark <- getSymbols("MICEX", src = "Finam", auto.assign = FALSE)[,4]

benchmarkRet <- na.omit(ROC(benchmark))Тоже самое для портфеля акций, плюс считаем портфель и включаем ребалансировку каждый месяц.PortReturn <- na.omit(ROC(PortPrices)) PortRet <- Return.portfolio(PortReturn, weights = weights, rebalance_on = "month")

PortCum <- cumsum(PortRet) Micex <- cumsum(benchmarkRet)

( Читать дальше )

Алгоритм анализа облигаций

- 29 сентября 2021, 20:06

- |

Приветствую! Напишу о том, как найти облигации, какие выбрать, как анализировать и купить.

Последний пост про рост инфляции заставил многих задуматься о том, как защитить деньги от обесценения, приумножить их в долгосрочном периоде и в то же время не влезать в переоцененные акции.

Многие просили написать про облигации. Я полностью согласен с тем, что облигации в текущих условиях оптимальный вариант инвестирования свободных денег. Поэтому по этим просьбам решил написать об этом инструменте.

Облигации играют важную роль в портфеле. У меня в портфелях они составляют 45% активов. В первую очередь, это ликвидный запас денег на случай снижения рынка акций. Во-вторых, это инструмент с понятной и стабильной доходностью в отличие от акций. Многие помнят, что я увеличиваю инвестиции в акции, когда рынок падает, поэтому в такие периоды облигационный резерв выступает источником покупки акций.

Проще говоря, когда рынок растет, я увеличиваю резерв из облигаций и покупаю акции на минимум. Когда рынок падает, я увеличиваю покупки акций и сокращаю облигационный резерв.

( Читать дальше )

- комментировать

- 11.1К |

- Комментарии ( 39 )

Все, что есть по OptionVictory (OptionFVV) в одном посте

- 26 сентября 2021, 16:22

- |

Канал на Youtube с уже тремя сериями видеоруководства, и продолжение будет — Плейлист видеоруководств

Telegram-канал, где публикуются объявления о релизах https://t.me/optionvictory

Сегодня вышел новый небольшой релиз с обновленнным и отлаженным выпадающим списком стратегий и доработанным калькулятором. Инструкции по обновлению прочтите на сайте.

Шаблон торговой системы на Python (backtrader, quantstats)

- 22 сентября 2021, 21:54

- |

Зачем Python?

Лично мне он показался удобнее. Например, можно быстро подключить telebot и система начнёт отправлять сигналы прямо в телегу на все девайсы. Работать со скриптами можно даже на айпаде где-нибудь в дороге, тоже плюс.

Самая простая система, которую можно потестить это пересечение двух скользящих средних: если быстрая SMA пересекает медленную вверх, то покупаем, а если вниз, то закрываем открытую позицию, шортить рынок не будем. Комиссии, проскальзывание и прочие расходы пока не учитываем, нужно начать с какой-то основы.

Что потребуется?

— backtrader для логики торговой системы

— quantstats для формирования отчёта

— Jupyter Notebook, если нужно удобнее редактировать код

( Читать дальше )

Анализ и визуализация данных в финансах — анализ ETF с использованием Python

- 18 сентября 2021, 00:55

- |

1. О данных

Для анализа будем использовать данные ETF c базовой валютой USD: FXCN, FXRL, FXIT, FXUS и FXRU. Временной ряд рассмотрим за три года с 2018 по 2020 года. Само исследование проведем в Google Colaboratory.

Как обычно в начале импортируем все необходимые библиотеки для дальнейшей работы.

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

from google.colab import files

import warnings

warnings.filterwarnings("ignore")Сначала необходимо получить данные. Есть несколько способов. Мы воспользовались — взяли их с Finam в формате csv. Дальше написал функцию для обработки полученных данных и при помощи concat свел их в один датафрейм.def changeDF(df): df['date'] = pd.to_datetime(df['<DATE>'].astype(str), dayfirst=True) name =[x for x in globals() if globals()[x] is df][0] df = df.drop(['<DATE>','<TIME>', '<OPEN>', '<HIGH>', '<LOW>'], axis=1) df = df.set_index(['date']) df.columns = [name+'_cl', name + '_vol'] return df fxgd_change = changeDF(fxgd) fxrl_change = changeDF(fxrl) fxit_change = changeDF(fxit) fxus_change = changeDF(fxus) fxru_change = changeDF(fxru) fxcn_change = changeDF(fxcn) etf = pd.concat([fxgd_change, fxrl_change, fxit_change, fxus_change, fxru_change, fxcn_change], axis=1) etf.head()В результате получили:

( Читать дальше )

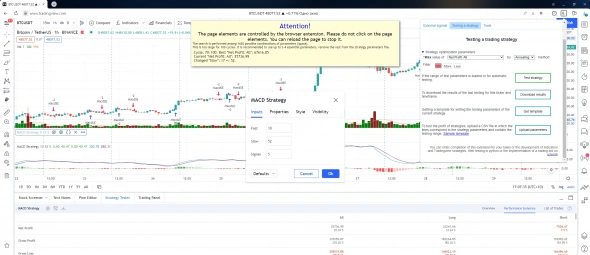

Автоматический бактестинг стратегии в TradingView с сохранением результатов в CSV

- 17 сентября 2021, 11:52

- |

Если вы используете стратегии в трейдингвью, например чтобы быстро накидать прототип идеи из какого нибудь источника и посмотреть её, то у вас наверняка также появлялся вопрос поиска приемлемых параметров и проверка как они влияют на стратегию. Делать это вручную крайне трудозатратно. Простейшая стратегия двух скользящих средних может давать 400 и более вариантов параметров. А любое увеличение кол-ва параметров и диапазона их значений приводит к необходимости перебора значений растущих в геометрической прогрессии. Например стратегия из 5 параметров по 15 значений дает 15 ^ 5 = 759 375 вариантов. Подобрать их руками, когда один вариант вычисляется пару секунд не реально.

А можно ли автоматизировать этот процесс? Ниже описание решения через расширение для браузера на основе Chrome.

В прошлый раз я публиковал статью, в которой говорил об ассистенте для

( Читать дальше )

Алгоритмический трейдинг для профессионалов. Е.Малыхин (отзыв о книге)

- 16 сентября 2021, 11:24

- |

Поскольку на рынке наблюдается дефицит отечественных книг по теме алготорговли, то каждая выходящая книга читается на одном дыхании с нескрываемым интересом.

Малыхин Евдоким Михайлович серьезный практик, кандидат физико-математических наук и эксперт в области разработки программного обеспечения. И этот факт ощущается уже с чтения первых строк книги. В книге нет никаких кодов торговых роботов или готовых алгоритмов. Она немного о другом — а именно об инженерном подходе к построению алгоритмов и программ. Книга не для новичков, для ее чтения требуется определенный собственный опыт разработки роботов и шишки от граблей.

В ней описано:

— назначение и функции роботов;

— как архитектурировать программы;

— как создавать, аудировать, и развивать свою алгоритмическую систему;

— виды обрабатываемых данных и их особенности;

— масштабируемость и жизненный цикл роботов;

— управление рисками в алготрейдинге (в т.ч. описываются риски программного кода, железа, средств связи, методы вскрытия ошибок до выхода программы в эксплуатацию);

( Читать дальше )

- bitcoin

- brent

- eurusd

- forex

- gbpusd

- gold

- imoex

- ipo

- nyse

- s&p500

- si

- usdrub

- акции

- алготрейдинг

- алроса

- анализ

- аналитика

- аэрофлот

- банки

- биржа

- биткоин

- брокеры

- валюта

- вдо

- волновая разметка

- волновой анализ

- вопрос

- втб

- газ

- газпром

- гмк норникель

- дивиденды

- доллар

- доллар рубль

- дональд трамп

- евро

- золото

- инвестиции

- инвестиции в недвижимость

- индекс мб

- инфляция

- китай

- ключевая ставка цб рф

- кризис

- криптовалюта

- лукойл

- магнит

- ммвб

- мобильный пост

- мосбиржа

- московская биржа

- мтс

- натуральный газ

- нефть

- новатэк

- новости

- обзор рынка

- облигации

- опрос

- опционы

- отчеты мсфо

- офз

- оффтоп

- прогноз

- прогноз по акциям

- путин

- раскрытие информации

- роснефть

- россия

- ртс

- рубль

- рынки

- рынок

- санкции

- сбер

- сбербанк

- северсталь

- смартлаб

- сущфакты

- сша

- технический анализ

- торговля

- торговые роботы

- торговые сигналы

- трамп

- трейдинг

- украина

- фондовый рынок

- форекс

- фрс

- фьючерс

- фьючерс mix

- фьючерс ртс

- фьючерсы

- цб

- цб рф

- экономика

- экономика россии

- юмор

- яндекс

Новости тг-канал

Новости тг-канал