нейронная сеть

О тех индикаторах с точки зрения нейросетей.

- 12 октября 2020, 10:16

- |

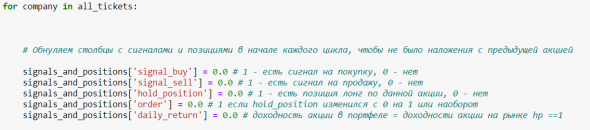

Месяц назад я пробовал подать на вход CNN+GramianAngular падение/рост рынка, без каких то видимых успехов. Может тут проблема в инструменте? Попробуем спрогнозировать с помощью нейросети срабатывание этих самых техиндикаторов, подав цены накануне. Причем усложним задачу, будем подавать не точное число баров, а фиксированное, скажем 30. То есть нейросетка получает избыточные данные: мы хотим предсказать пересечение Close c SMA(25) а мы ей 30 баров предлагаем.

( Читать дальше )

- комментировать

- 3.8К

- Комментарии ( 17 )

Чем меньше риск, тем больше доходность. Fact and fiction о риске и доходности на Московской бирже Vol 2. Коллекция простых и сложных бэктестов: от скользящих средних до нейронки

- 17 августа 2020, 16:48

- |

Привет, после небольшого перерыва возвращаемся к бэктестам. Добавим к простой трендовой стратегии на Мосбирже 4 варианта выхода из позиций с возрастающим уровнем сложности. Для первых двух стратегий особых навыков не требуется, третья требует парсинга Телеграма и для последней потребуется обученная нейронная сеть при разметке сообщений.

Это продолжение рассуждений о риске и доходности акций на Московской бирже: https://smart-lab.ru/blog/625771.php Основные выводы из первой части:

1) Увеличение риска (стандартного отклонения) приводит к снижению будущей доходности акций, а не наоборот;

2) Стратегия, выстроенная только на основе исторической волатильности, несамостоятельна и проигрывает индексу.

В этот раз возьмем за основу трендовую стратегию в самом простом виде – на пересечении 1-месячной и 3-х месячной скользящей средней. И будем снижать риск разными способами с целью поднять доходность, Шарп, сократить время боковиков и корреляцию с бенчмарком. Об эффективности трендовых стратегий в России можно почитать здесь https://smart-lab.ru/blog/611263.php на глобальных ETF здесь

( Читать дальше )

Где найти программиста для робота на рынке РТС?

- 12 апреля 2020, 00:06

- |

Блеск и нищета ИСКУСТВЕННЫХ нейронных сетей

- 20 февраля 2020, 20:00

- |

В связи с хайпом вокруг искуственных нейронных сетей стало интересно: насколько реально обучить сеть или дерево или иную технологию машинного обучения для восстановления вида неизвестной функции по следующим значениям обучающей выборки:

- x==4 тогда y==40

- x==61 тогда y==80

- x==117 тогда y==120

Сеть или дерево должна вычислить значение этой функции для аргумента x==97853

Философский подтекст состоит в том, что человек в состоянии определить вид этой функции совершенно достоверно и получить нулевую ошибку на валидационной выборке любого размера и сложности.

Если технологии ML не могут дать адекватного ответа на этот вопрос, то могут ли они в принципе быть полезны в торговле?

UPDATE 1: За прошедшие несколько часов 2 человека однозначно продемонстрировали способность восстановить вид искомой функции. Что подтверждает простоту озвученной задачки.

( Читать дальше )

MVP на нейронных сетях

- 31 января 2020, 10:37

- |

Наконец дошли руки сделать работающий прототип на нейронных сетях — сразу же получился результат близкий к текущей используемой модели на основе градиентного бустинга. Учитывая, что в нейронные сети подавалась только часть информации по сравнению с той, которая используется для построения признаков для градиентного бустинга, и пара простых архитектур без всякой оптимизации, то есть все шансы в перспективе обойти градиентный бустинг. Из минусов — сетки обучаются в разы медленнее бустинга, но для моей инвестиционной стратегии это не принципиально.

Сходил недавно на семинар по эволюционному поиску нейросетевых архитектур — очень проникся темой. Пока останусь на градиентном бустинге, но буду двигаться в сторону сетей и эволюционного поиска их архитектур. В какой-то момент столкну бустинг и сети в эволюционном процессе, а там посмотрим, кто победит.

Вечер ML на SL: нейронка для RI

- 12 ноября 2019, 21:23

- |

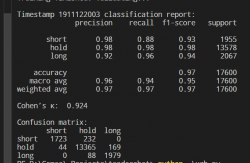

Если грубо, то каппа это показатель, который можно трактовать как преимущество прогнозной модели в сравнении с тупым рандомом. F1 это мера, которая определяет, насколько точна модель (отсутствие ложных предсказаний) и одновременно насколько она чувствительна (кол-во пропущенных мячей). Полученные по ним значения 0.924 и >0.9 соответственно, это совершенно запредельная точность «на бумаге».

Что касается confusion matrix, то её можно трактовать как соотношение предсказаний и реальных значений. Как видно, тут тоже всё вроде бы ок, ни один шорт как лонг не был классифицирован и наоборот.

Погонял сейчас на вечёрке, но, как и следовало ожидать, на реальных биржевых данных всё оказалось далеко не так радужно:

( Читать дальше )

От градиентного бустинга к нейронным сетям

- 27 сентября 2019, 17:43

- |

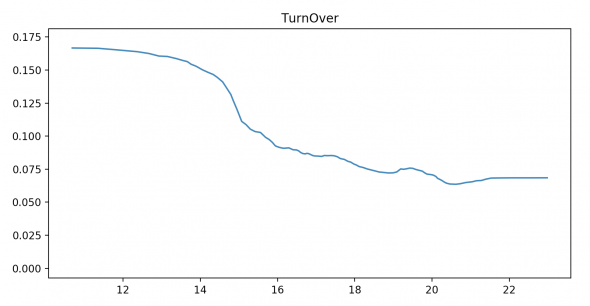

В последние время причесал некоторые блоки своей программки по управлению портфелем. Из последнего добавил в качестве фичи оборот и получил известную зависимость, что малоликвидные бумаги в среднем имеют большую доходность (по горизонтали натуральный логарифм дневного оборота, по вертикали ожидаемая доходность).

По большому счету дальше можно лишь потихоньку расширять перечень анализируемых бумаг и добавлять новые признаки, объясняющие доходность, но придумывать в рукопашную новые фичи не хочется, поэтом попробую переписать все на нейронных сетях и сырых котировках без всякой обработки.

В основном раньше имел дело с TF/Keras, но по ощущениям в последнее время подавляющая часть статей по сетям сопровождается кодом на PyTorch, поэтому решил изучить его и использовать в своей программе. В качестве обучения собираюсь принять участие в соревновании Кто поставит лайк без использования градиентного бустинга только с помощью PyTorch. Ну о потом приступить уже к использованию сеточек для прогнозирования доходности.

Нейронные сети для трейдеров

- 23 сентября 2019, 07:37

- |

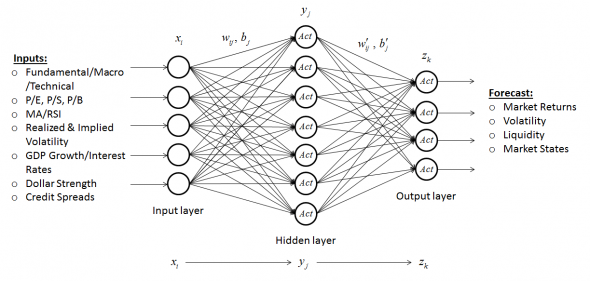

Искусственная нейронная сеть позволяет моделировать некую нелинейную функцию с входными и выходными данными.

( Читать дальше )

Про Нейронную Сеть, создаем и развиваемся.

- 26 июня 2019, 17:30

- |

Приветствую вас, любители трейдинга!

Видел на смартлабе посты про Пайтон (Python), читать их было очень интересно, в том числе и про то, как НС торгует на бирже. В настоящее время Пайтон (https://www.python.org/) занимает 3 строчку в рейтинге по языкам программирования (https://www.tiobe.com/tiobe-index//). Сам изучал в детстве бейсик (Basic), потом паскаль (Pascal) и далее посмотрел множество языков программирования, вплоть до ассемблера. Самый тяжелый С++)), а все потому, что у него код пишется сокращенными символами, например «начало» и «конец» программы обозначались фигурными скобками «{ …здесь код… }», а у паскаля «begin» и «end». Согласитесь, проще запомнить слова, чем множество лишних для нас символов, которые хранятся у нас в головном мозге, нейронных клетках. Программировал из любопытства.

Я хочу поделиться с вами, про Нейронную сеть (НС), что меня заставляет двигаться в этом направлении вперед. Простую НС теперь может создать любой желающий, даже ребенок с 6 лет сможет понять суть работы НС и попробовать написать программу. Программировать можно через веб-сайт, например Гугол (Google) сделал потрясающую колабораторию (так он ее называет) для программирования на Пайтон (https://colab.research.google.com/).

( Читать дальше )

команда молодых программистов из Невады разуверились в своих силах через нейронную сеть.

- 09 ноября 2018, 17:04

- |

Эксперимент прошел на всех ликвидных бумагах, с историей не менее 10 лет

В итоге,

за месяц было найдено более 300 патернов.

за три месяца чуть более 70.

за год не более 27 за каждый год.

в течении всей истории 0.

Вывод, рынок никогда не будет таким как был вчера.

Бот не смог найти ни одного патерна который мог бы любому из нас, дать 100% преимущество выигрыша!

Но чудаки всё переводят в проценты, и действительно были найдены патерны которые в 70% случаев, приводили к положительному результату, именно этот метод сейчас и заложен в работу.

- bitcoin

- brent

- eurusd

- forex

- gbpusd

- gold

- imoex

- ipo

- nyse

- rts

- s&p500

- si

- usdrub

- акции

- алготрейдинг

- алроса

- аналитика

- аэрофлот

- банки

- биржа

- биткоин

- брокеры

- валюта

- вдо

- волновая разметка

- волновой анализ

- вопрос

- втб

- газ

- газпром

- гмк норникель

- дивиденды

- доллар

- доллар рубль

- дональд трамп

- евро

- золото

- инвестиции

- инвестиции в недвижимость

- индекс мб

- инфляция

- китай

- ключевая ставка цб рф

- кризис

- криптовалюта

- лукойл

- магнит

- ммвб

- мобильный пост

- мосбиржа

- московская биржа

- мтс

- натуральный газ

- нефть

- новатэк

- новости

- обзор рынка

- облигации

- опрос

- опционы

- отчеты мсфо

- офз

- оффтоп

- прогноз

- прогноз по акциям

- путин

- раскрытие информации

- ри

- роснефть

- россия

- ртс

- рубль

- рынки

- рынок

- санкции

- сбер

- сбербанк

- северсталь

- смартлаб

- сущфакты

- сша

- технический анализ

- торговля

- торговые роботы

- торговые сигналы

- трамп

- трейдинг

- украина

- фондовый рынок

- форекс

- фрс

- фьючерс

- фьючерс mix

- фьючерс ртс

- фьючерсы

- цб

- цб рф

- экономика

- юмор

- яндекс

Новости тг-канал

Новости тг-канал