Data Mining

Данные говорят. Корреляция графиков зависимости лонга и шорта от значения параметра.

- 02 апреля 2019, 12:21

- |

Всем привет. С вами рубрика «Данные говорят». Да, это первый выпуск в этой рубрике). В этой рубрике мы будем разговаривать с данными. Нет, я не сошел с ума. Данные будут говорить, а я только слушать. А с вами данные тоже разговаривают?

Погнали. Под данными в данном случае имею в виду числа, графики числовых рядов, таблички и аналогичное. В данном конкретном случае речь про числа, графики, таблички по итогам бэктестов стратегии (её болванки, или другими словами корневой идеи).

Если уметь слушать данные, то можно многое услышать – например, например, можно находить баги в коде стратегии, интересные идеи, резервы и т.д. Затягиваешь параметром диапазон значений, а число трейдов растёт? – Ну значит где-то баг. Если вслушиваться в данные – иногда можно идентифицировать не только факт наличие бага, но и его локализацию и характер.

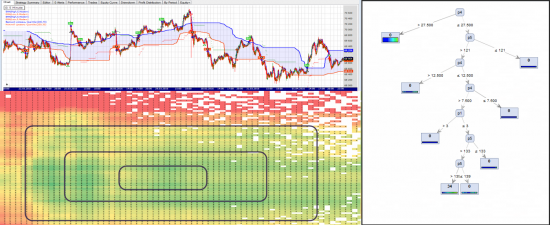

Теперь конкретней про «корреляция графиков зависимости лонга и шорта от значения параметра». Наверно, по формулировке не очень понятно, о чем речь. Тем более, предположу, что так глубоко и в эту сторону копают не только лишь все. Поэтому поясню: допустим, я хочу понять роль параметра А в стратегии, самый простой вариант – не шевеля параметры Б, В, Г и Д, перебирать А с некоторым шагом. Вот мы пошевелили А, не шевеля Б, В, Г, Д. А теперь для каждого прогона посчитали, допустим Profit Factor (возьмем его условно за некий показатель, характеризующий качество стратегии) отдельно для лонговых позиций и отдельно для шортовых. Ну и построили два графика – значение PF в зависимости от А для лонга и значение PF в зависимости от А для шорта. Так вот, иногда/часто эти графики будут прилично коррелировать.

( Читать дальше )

- комментировать

- Комментарии ( 15 )

Парсинг постов Смартлаба. Темы декабря 2018

- 12 января 2019, 16:10

- |

Предлагаю вашему вниманию новый пост о применении data mining к текстам, спарсенным из блогов Смартлаба.

Идея исследования: ежемесячно парсить все посты со Смартлаба и применять к ним метод из класса методов тематического моделирования.

В прошлый раз был применён метод BigARTM из класса методов тематического моделирования. Ряд темы оказались не вполне интерпретируемы. Кроме того этот метод — несмотря на всю его прогрессивность (детальное описание: Воронцов К.В. Вероятностное тематическое моделирование: обзор моделей и аддитивная регуляризация) по сравнению со, скажем, методом LDA - не лишён существенных недостатков. Так, он не позволяет юзеру автоматически выбирать число тем, а также не предлагает метрики для выяснения, какую долю исходной информации позволяет сохранить модель в целом и отдельные темы — в частности

Поэтому моя команда разработала собственный оригинальный метод тематического моделирования. Он позволяет группировать слова («термы», «токены») из множества документов по темам. При этом — в отличие от большинства аналогов — он позволяет автоматически выбирать число тем, а также включает простые и понятные метрики, которые позволяют выяснить, какую долю исходной информации позволяет сохранить модель в целом и отдельные темы — в частности.

( Читать дальше )

Google Colab: Российский рынок - по многочисленным просьбам

- 10 января 2019, 12:18

- |

Низкий порог входа в мир серьёзного анализа данных -тем и привлекателен этот зоопарк. Несколько строк кода и уже можно анализировать-смотреть данные (акции, облигации, фьючи, макро).

Если вы пробовали писать скрипты в Excel, кастомные индикаторы в Мультичартсах или Метастоках, то освоить язык Python в интерактивной среде Jupyter Notebook (Google Colab — даёт бесплатный доступ) — посильное занятие.

Для американского рынка есть библиотека (-ки), которые позволяют подкачать биржевые и экономические данные — я писал об этом. Кстати к

( Читать дальше )

Парсинг постов Смартлаба. Темы октября 2018

- 14 ноября 2018, 15:39

- |

Предлагаю вашему вниманию пробный пост о применении data mining к текстам, спарсенным из блогов Смартлаба.

Идея исследования: ежемесячно парсить все посты со Смартлаба и применять к ним метод BigARTM из класса методов тематического моделирования.

Методы тематического моделирования (детальное описание: Воронцов К.В. Вероятностное тематическое моделирование: обзор моделей и аддитивная регуляризация) позволяют группировать слова («термы», «токены») из множества документов по темам.

Интерпретация тем – дело исследователя. К сожалению, не всегда удаётся проинтерпретировать набор слов, т.е. по этому набору назвать тему. Я буду приводить как наборы слов по темам, так и мою интерпретацию тем. Вы же при желании сможете дать свою интерпретацию.

В дальнейшем – при накоплении статистики – можно искать связи между событиями и их отражением или не отражением в виде постов на Смартлабе.

В октябре 2018 на смартлабе было опубликовано свыше 4000 постов.

( Читать дальше )

Где легче майнить идеи?

- 19 сентября 2018, 15:29

- |

Кто-нибудь обращал внимание на подобную закономерность? — В смысле она вообще есть? — Далее о самой возможной закономерности.

Есть такое понятие ниша. Эта штука работает везде — в бизнесе, в трейдинге, где угодно — универсальное понятие. После появления крипты, наприме, через какое-то время сформировалась ниша или группа ниш — там лежало бабло — много бабла, мало конкуренции, как результат низкие усилия на то чтобы взять бабло. Это основной принцип ниш — именно такая связь между объемом лежащего бабла, конкуренцией и легкостью получения бабла в пределах ниши.

В трейдинге ниши есть, например, при майнинге идей. В финансовых рынках миллион разных закоулков, нюансов, деталей, способов анализа, методов и подходов, миллион инструментов и т.д. И я почти уверен, что здесь эта тема с нишами так же работает. И вот интересно, кто-то на себе это замечал? — что если вдруг выходишь на нехоженую тропу, то возможности, неэффективности гроздьями вдоль дороги валяются и все сплошь рабочие. Есть такое? — Или закономерности и неэффективности размазаны ровным слоем? — Или все-таки стоит поощрять себя активно включать креативное мышление и пытаться найти те самые нехоженые тропы, нежели выдаивать что-то что уже давно лишено жизненных соков?

В явном виде я такую связь не замечал, но умозрительно мне кажется, что она должна быть.

Добрый день! Где найти исторические данные по криптовалютам? Максимум токенов, валют, активов. Биржи любые. Спасибо!

- 18 декабря 2017, 23:28

- |

Выкладываю тиковые исторические данные

- 05 мая 2016, 11:02

- |

Мне, и думаю многим другим, нужны качественные исторические данные за максимальный промежуток времени — для изучения рынка, построения и тестирование торговых систем. Такие данные по фьючерсам, торгуемым на западе, в частности на CME, в свободном доступе (кроме дневок) практически не найти. Несколько месяцев назад я купил исторические данные по следующим фьючерсам CME: ES (фьючерс на индекс S&P), CL (фьючерс на нефть WTI), GC (фьючерс на золото), NQ (фьючерс на индекс NASDQ). Спецификацию по ним вы можете посмотреть тут: http://smart-lab.ru/blog/320021.php

Но осталась потребность в данных по многим другим интересным инструментам. И пару недель назад у меня появилась идея – т.к. исторические данные нужные не только мне, то вполне возможно приобретать их совместно (в складчину) (http://smart-lab.ru/blog/317451.php)

( Читать дальше )

Это нужно для успешной системной торговли: обновление исторических данных

- 20 апреля 2016, 16:09

- |

Выкладываю обновление по историческим данным:

5 минутные OHLCV

Данные по ES, GC, CL, NQ, NG с самого начала (15 и более лет) по 08.04.2016 тутДанные по ES, GC, CL, NQ, NG с 08.04.2016 по 15.04.2016 тут

Качественные тиковые данные

ES — c 10.09.1997 по текущий момент

CL – с 02.01.1987 по текущий момент

GC — c 03.01.1984 по текущий момент

NQ - c 01.07.1999 по текущий момент

NG — с 04.01.1993 по текущий момент

HG – с 12.01.1989 по текущий момент

Обращайтесь в личку

- bitcoin

- brent

- eurusd

- forex

- gbpusd

- gold

- imoex

- nasdaq

- nyse

- rts

- s&p500

- si

- usdrub

- wti

- акции

- алготрейдинг

- анализ

- аналитика

- аэрофлот

- банки

- биржа

- биткоин

- брокеры

- валюта

- вдо

- волновой анализ

- волны эллиотта

- вопрос

- втб

- газ

- газпром

- гмк норникель

- дивиденды

- доллар

- доллар рубль

- евро

- ецб

- золото

- инвестиции

- инфляция

- китай

- коронавирус

- кризис

- криптовалюта

- лидеры роста и падения ммвб

- лукойл

- магнит

- ммвб

- мобильный пост

- мосбиржа

- московская биржа

- нефть

- новатэк

- новости

- обзор рынка

- облигации

- опек+

- опрос

- опционы

- офз

- оффтоп

- прогноз

- прогноз по акциям

- путин

- раскрытие информации

- ри

- роснефть

- россия

- ртс

- рубль

- рынки

- рынок

- санкции

- сбер

- сбербанк

- си

- сигналы

- смартлаб

- сущфакты

- сша

- технический анализ

- торговля

- торговые роботы

- торговые сигналы

- трейдер

- трейдинг

- украина

- финансы

- фондовый рынок

- форекс

- фрс

- фьючерс

- фьючерс mix

- фьючерс ртс

- фьючерсы

- цб

- шорт

- экономика

- юмор

- яндекс

Новости тг-канал

Новости тг-канал