смартлаб

про

- 16 января 2019, 23:34

- |

- комментировать

- Комментарии ( 22 )

Торгуем нефтью вместе с FullCup 16.01.2019

- 16 января 2019, 09:01

- |

Ремарка: БЛАГОДАРЕН И ПРИЗНАТЕЛЕН МОИМ ЧИТАТЕЛЯМ ЗА ПЛЮСЫ !

Пусть они вернутся Вам Удачей, Успехом и Благополучием !!!

.

Благополучного дня!

ТС в лонгах по 60,41; стоп на продажу на 60,27

.

Пилит....

.

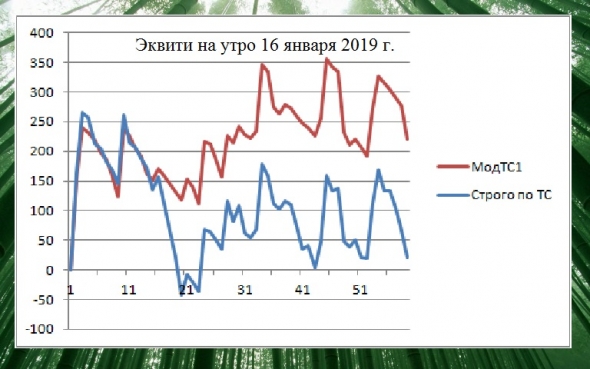

А это Эквити робота ТС в шагах (пунктах, центах) с начала января:

(По абсциссе — номер срабатывания сигнала ТС,

по ординате — результат в шагах (пунктах, центах) на один контракт.)

Можете это итоговое значение (в шагах на один контракт) умножить на стоимость шага (сейчас 6,63 рубля) и умножить на количество торгуемых Вами контрактов. Получите Вашу сумму профита в случае Вашей торговли по ТС с начала января.

.

P.S. Интересует полная и оперативная трансляция сигналов ТС — пишем в мою «личку» на Смартлабе.

( Читать дальше )

Тимофей, бери Zorro креатив директором.

- 16 января 2019, 03:28

- |

Тимофей, бери идею Zorro на карандаш. Посещаемость поднимешь раза в 3.

Необязательно с угадыванием значения бумаги, индекса.

Можно устраивать различные викторины. «Самая лучшая инвестиционная идея на неделю» например. Народ накидывает идеи субботу-вскр, по закрытию пятницы подводишь итог. Победителю десяточку. По итогам квартала, года можно рейтинг составлять.

Короче Zorro показал неплохое направление популяризации Смарта, на мой взгляд.

Торгуем нефтью вместе с FullCup 15.01.2019

- 15 января 2019, 09:20

- |

❤

Ремарка: БЛАГОДАРЕН И ПРИЗНАТЕЛЕН МОИМ ЧИТАТЕЛЯМ ЗА ПЛЮСЫ !

Пусть они вернутся Вам Удачей, Успехом и Благополучием !!!

.

Благополучного дня!

ТС в лонгах по 59,16; стоп на продажу на 58,97

.

Этот системный перенос через ночь оказался удачным! Ведь даже по-человечески не верилось...

.

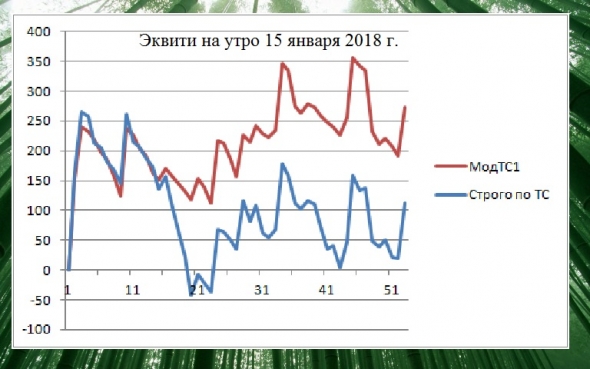

А это Эквити робота ТС в шагах (пунктах, центах) с начала января:

(По абсциссе — номер срабатывания сигнала ТС,

по ординате — результат в шагах (пунктах, центах) на один контракт.)

( Читать дальше )

Торгуем нефтью вместе с FullCup 14.01.2019

- 14 января 2019, 08:43

- |

Ремарка: БЛАГОДАРЕН И ПРИЗНАТЕЛЕН МОИМ ЧИТАТЕЛЯМ ЗА ПЛЮСЫ !

Пусть они вернутся Вам Удачей, Успехом и Благополучием !!!

.

Благополучного дня!

ТС в лонгах по 60,55; стоп на продажу на 60,34

Мда, ненужный был лонг на закрытии… Жаль...

.

С роботом ТС и счетом, на котором робот сам торгует, всё норм. Внизу, как обычно, выложу Эквити с ШЕСТЬЮ вишенками.

А вот по другим двум счетам случился «epic fail». Решил, что на плохих прогнозах по Apple пойдем вниз и вшортил, получилось на лоях...

Жаль, так что и по моему основному счету, и на стратегии автоследования тоже случилась жуткая просадка...

.

А это Эквити робота ТС в шагах (пунктах, центах) с начала января:

(По абсциссе — номер срабатывания сигнала ТС,

( Читать дальше )

Рацпредложение Тимофею Мартынову по SMART-LAB'у.

- 13 января 2019, 18:26

- |

Я на 101% уверен, что на СЛ много людей, которые устали читать про «биатлон» и прочие «скандалы, интриги, расследования».

Прошу поддержать мою идею всех неравнодушных, по улучшению интерфейса сайта для тех кто не хочет читать про «биатлон»!

Недавно справа в меню сайта появилось удобное разделение хороших постов, по лайкам, «избранности» и комментариям.

Почему по этому же подобию не сделать меню по темам постов!

( Читать дальше )

Тимофей Мартынов, Пора Ликвидировать!

- 13 января 2019, 13:22

- |

Друг мой Тима, Тимофей Мартынов !

Ушедший, 2018-й год показал (как минимум, дважды, апрель-декабрь!), что биржевая торговля может быть очень бО'льной и плачевной для тех, кто недооценил все связанные с нею риски.

Главным образом, это касается молодых, только начинающих «Инвесторов» (спекулянтов, конечно же, готовых удвоить депозит за день).

Принимая во внимание историческую миссию СмартЛаба, а также то количество «юнцов неоперённых», ежедневно пополняющих стройные ряды сего безусловно достойного трейдерского ресурса, предлагаю:

1. Открыть новый раздел — «Риски Торговли».

2. Размещать в этом разделе статьи, посвящённые тем моментам, тем нюансам, которые (почему-то?) поленились озвучить всякого рода «обучалкины» на своих платных и прочих бесплатных курсах. С примерами.

И кое-что ещё, и кое-что другое,

О чём не говорят, чему не учат в школе...

( Читать дальше )

Парсинг постов Смартлаба. Темы декабря 2018

- 12 января 2019, 16:10

- |

Предлагаю вашему вниманию новый пост о применении data mining к текстам, спарсенным из блогов Смартлаба.

Идея исследования: ежемесячно парсить все посты со Смартлаба и применять к ним метод из класса методов тематического моделирования.

В прошлый раз был применён метод BigARTM из класса методов тематического моделирования. Ряд темы оказались не вполне интерпретируемы. Кроме того этот метод — несмотря на всю его прогрессивность (детальное описание: Воронцов К.В. Вероятностное тематическое моделирование: обзор моделей и аддитивная регуляризация) по сравнению со, скажем, методом LDA - не лишён существенных недостатков. Так, он не позволяет юзеру автоматически выбирать число тем, а также не предлагает метрики для выяснения, какую долю исходной информации позволяет сохранить модель в целом и отдельные темы — в частности

Поэтому моя команда разработала собственный оригинальный метод тематического моделирования. Он позволяет группировать слова («термы», «токены») из множества документов по темам. При этом — в отличие от большинства аналогов — он позволяет автоматически выбирать число тем, а также включает простые и понятные метрики, которые позволяют выяснить, какую долю исходной информации позволяет сохранить модель в целом и отдельные темы — в частности.

( Читать дальше )

- bitcoin

- brent

- eurusd

- forex

- gbpusd

- gold

- imoex

- ipo

- nasdaq

- nyse

- rts

- s&p500

- si

- usdrub

- wti

- акции

- алготрейдинг

- алроса

- аналитика

- аэрофлот

- банки

- биржа

- биткоин

- брокеры

- валюта

- вдо

- волновой анализ

- волны эллиотта

- вопрос

- втб

- газ

- газпром

- гмк норникель

- дивиденды

- доллар

- доллар рубль

- евро

- золото

- инвестиции

- индекс мб

- инфляция

- китай

- кризис

- криптовалюта

- лидеры роста и падения ммвб

- лукойл

- магнит

- ммвб

- мобильный пост

- мосбиржа

- московская биржа

- мтс

- нефть

- новатэк

- новости

- обзор рынка

- облигации

- опрос

- опционы

- отчеты мсфо

- офз

- оффтоп

- прогноз

- прогноз по акциям

- раскрытие информации

- ри

- роснефть

- россия

- ртс

- рубль

- рынки

- рынок

- санкции

- сбер

- сбербанк

- северсталь

- си

- сигналы

- смартлаб

- сущфакты

- сша

- технический анализ

- торговля

- торговые роботы

- торговые сигналы

- трейдер

- трейдинг

- украина

- фондовый рынок

- форекс

- фрс

- фьючерс

- фьючерс mix

- фьючерс ртс

- фьючерсы

- цб

- цб рф

- экономика

- юмор

- яндекс

Новости тг-канал

Новости тг-канал