Блог им. Koleso

Ученые предупреждают, что глубокие дипфейки вот-вот станут необнаруживаемыми

- 08 мая 2025, 08:43

- |

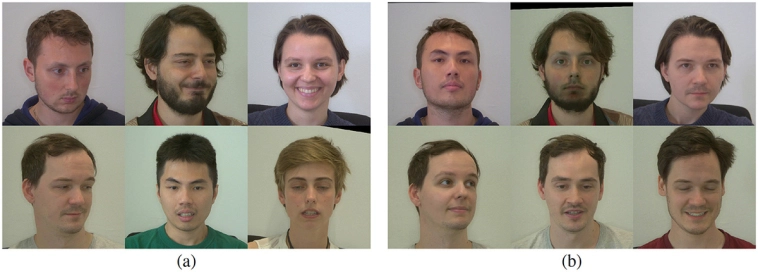

Можете ли вы сказать, кто настоящий, а кто фальшивый?

Можете ли вы сказать, кто настоящий, а кто фальшивый?Кратко

- •Детекторы дипфейков пытаются обойти обман, выискивая скрытые признаки, например, пульс.

- •Частота сердечных сокращений и пульс больше не могут противостоять продвинутым генеративным моделям дипфейков на основе ИИ.

- •Дипфейки могут использоваться для обмана в финансовых махинациях и распространения дезинформации.

- •Детекторы глубокой подделки сканируют видео на наличие пульса с помощью метода удалённой фотоплетизмографии.

- •Современные продвинутые инструменты для создания дипфейков могут имитировать реалистичное сердцебиение, но не могут достоверно отображать изменения кровотока.

- •Крупные технологические компании разрабатывают системы цифровых водяных знаков для отслеживания обработки контента с помощью ИИ.

Видео, созданные искусственным интеллектом, могут «наследовать» сердцебиение человека, что затрудняет их распознавание.

Сгенерированные искусственным интеллектом видеоролики с дипфейками, на которых изображены люди, с каждым днём становятся всё более продвинутыми и распространёнными. Самые сложные инструменты теперь могут создавать контент с манипуляциями, который не отличим от оригинала для среднестатистического человека.

Детекторы дипфейков, которые используют собственные модели искусственного интеллекта для анализа видеозаписей, пытаются обойти этот обман, выискивая скрытые признаки. Одним из них является наличие человеческого пульса. В прошлом модели искусственного интеллекта, которые обнаруживали заметный пульс или частоту сердечных сокращений, могли с уверенностью классифицировать такие ролики как подлинные. Но, возможно, это уже не так.

Исследователи из Берлинского университета имени Гумбольдта опубликовали на этой неделе в журнале Frontiers in Imaging исследование, в котором они создали видео с дипфейками, на которых у людей были видны человеческие импульсы. Детекторы дипфейков, обученные использовать импульсы в качестве маркера подлинности, неправильно классифицировали эти отредактированные видео как реальные.

Полученные результаты свидетельствуют о том, что частота сердечных сокращений и пульс, которые когда-то считались относительно надёжными индикаторами подлинности, больше не могут противостоять самым продвинутым генеративным моделям дипфейков на основе ИИ. Другими словами, постоянная игра в кошки-мышки между создателями дипфейков и теми, кто их разоблачает, может склоняться в пользу обманщиков.

«Здесь мы впервые показываем, что недавние высококачественные видео с дипфейками могут содержать реалистичное сердцебиение и едва заметные изменения цвета лица, что значительно усложняет их обнаружение», — говорится в заявлении профессора Берлинского университета имени Гумбольдта и соавтора исследования Питера Айзерта.

Как работают глубокие подделки и почему они опасныТермин «дипфейк» в широком смысле относится к технологии искусственного интеллекта, которая использует глубокое обучение для манипулирования медиафайлами. С помощью дипфейков можно создавать изображения, видео и аудио с разной степенью реалистичности. Хотя в некоторых случаях использование этой технологии может быть относительно безобидным, она быстро приобрела дурную славу из-за всплеска популярности сексуальных изображений, созданных без согласия. Независимый исследователь, выступивший в 2023 годув интервью с Wired, подсчитал, что всего за семь дней на 35 самых популярных порносайтов с дипфейками было загружено около 244 625 видео с подменой лиц. Недавнее появление так называемых приложений для обнажения на смартфонах ещё больше усугубило проблему, позволив людям, не обладающим техническими знаниями, вставлять чьё-либо лицо в откровенные изображения одним нажатием кнопки.

На расположенных рядом изображениях слева показаны фотографии реальных участников, а справа — их клоны, созданные с помощью ИИ. Изображение: Питер Айзерт

На расположенных рядом изображениях слева показаны фотографии реальных участников, а справа — их клоны, созданные с помощью ИИ. Изображение: Питер АйзертЕсть также опасения по поводу других примеров дипфейков, особенно аудио- и видеоверсий, которые используются для того, чтобы обманом заставить людей попасться на финансовые махинации. Другие опасаются, что эта технология может быть использована для создания убедительных копий законодателей и других влиятельных фигур с целью распространения дезинформации. Дипфейки уже распространились, изображая президентов Барака Обаму и Дональда Трампа, а также многих других общественных деятелей. Только на этой неделе Конгресс принял противоречивый новый законопроект под названием «Прими меры», который предусматривает уголовную ответственность за публикацию и распространение сексуальных изображений без согласия, в том числе созданных с помощью ИИ.

В продолжение:Как детекторы глубокой подделки сканируют видео на наличие импульса

Детекторам, возможно, потребуется адаптироваться к новой реальности

Подпишитесь на канал "Жизнь Дурова: ЗОЖ, деньги, ИТ" — все самое главное о здоровье, технологиях и деньг

теги блога Андрей Колесников

- Amazon

- bitcoin

- ChatGPT

- ETF

- ICO

- netflix

- OpenAI

- telegram

- акции

- банки

- баффет

- безработица

- Биохакинг

- биткоин

- блокчейн

- видеоКонспект

- газпром

- геополитика

- геронтология

- демография

- долголетие

- Доллар рубль

- дональд трамп

- здоровье

- ЗнанияСжато

- ЗОЖ

- золото

- ИИ

- Илон Маск

- инвестирование

- инвестиции

- Инновации

- инфляция

- искусственный интеллект

- история

- история России

- Китай

- коронавирус

- короновирус

- Красная Таблетка-2

- кризис

- кризис 2020

- кризис2020

- криптовалюта

- магия утра

- ментальные ловушки

- меры поддержки бизнеса

- мировая экономика

- мобильный пост

- Мовчан

- мозг

- Мошенничество

- мышление

- нейробиология

- Нефть

- Облигации

- олигархи

- опек+

- опрос

- оффтоп

- пандемия

- Пелевин

- поведенческая экономика

- подсознание

- предпринимательство

- психология

- Путин

- ресурсное "проклятие"

- Рэй Далио

- самодисциплина

- саморазвитие

- санкции

- сбербанк

- СВО

- Собянин

- стартапы

- счастье

- сша

- ТГ-канал kudaidem

- ТГ-канал SmartEventMos

- технологии

- Трамп

- трейдинг

- уоррен баффетт

- Утро

- финам

- форекс

- ФРС

- футурология

- цифровизация

- экономика

- экономика Китая

- экономика России

- экономика США

- экономическая история

- эмиграция

- Энергетический кризис

- эффективность

- Яндекс