Блог компании Positive Technologies | Бот или не бот: 60-летняя модель ИИ превзошла GPT-3.5 в тесте на «человечность»

- 10 декабря 2023, 14:47

- |

Британский ученый Алан Тьюринг, известный своими работами в области математики и криптографии, задумался о том, может ли машина мыслить и общаться с людьми наравне с человеком. Эти размышления привели ученого к созданию теста в 1950 году. Суть теста проста: пользователь общается с машиной и с человеком, не зная, кто из них кто, и пытается определить, с кем он ведет диалог. Если участник не может отличить машину от человека, считается, что машина успешно прошла тест. В настоящее время тест Тьюринга применяется для проверки чат-ботов на «человечность», выявляя умения ИИ выдавать себя за людей.

Проходит ли GPТ-4 тест Тьюринга?

В недавнем исследовании под названием «Проходит ли GPТ-4 тест Тьюринга?», ученые из Калифорнийского университета в Сан-Диего провели занимательное сравнение между живыми людьми и популярными моделями искусственного интеллекта GPT-3.5 и GPT-4. Кроме того, в исследовании принял участие виртуальный собеседник ELIZA, написанный в далеком 1966 году для пародирования общения психоаналитика с клиентами.

Детали эксперимента

Исследователи из Калифорнийского университета в Сан-Диего создали сайт под названием turingtest.live, где разместили онлайн-реализацию теста Тьюринга для двух участников, чтобы выяснить, насколько хорошо чат-боты могут убедить людей в своей «человечности».

В эксперименте, организованном на сайте turingtest.live, участвовало 652 человека, которые провели в общей сложности 1 810 сессий, 1 405 из которых были впоследствии проанализированы.

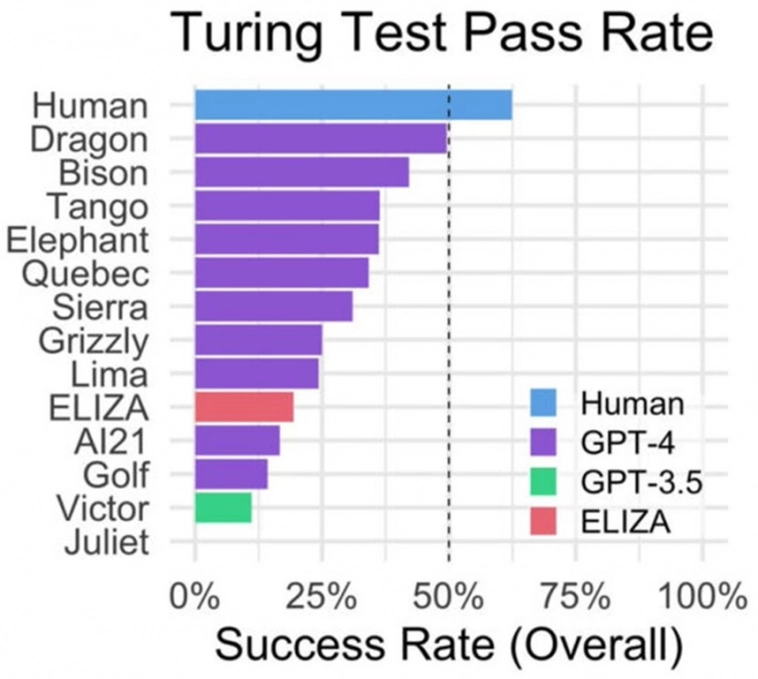

Исследование показало, что людей «по ту сторону экрана» участники эксперимента правильно определили в 63% случаев, а в 37% необоснованно посчитали их ботами. Согласно результатам, самой «человечной» моделью ИИ стала GPТ-4, показавшая результат в 41% и уступившая лишь реальным людям.

Однако самый большой сюрприз преподнес «ветеран» — чат-бот-ELIZA, чьи результаты превзошли самые смелые ожидания ученых. Показатель успешности этой языковой модели составил 27%, значительно превысив результат «молодой» GPT-3.5, базовой модели бесплатной версии ChatGPT, которая продемонстрировала всего 14% успеха.

Неожиданный успех «Элизы» и провал GPT-3.5

По мнению исследователей, модель ELIZA достигла успеха благодаря своим консервативным ответам, которые делали ее похожей на «несговорчивого собеседника», и тому, что она не проявляла качеств, характерных для современных языковых моделей, таких как услужливость и многословие. Интересно, что многие участники эксперимента подумали, что ELIZA — «слишком плохая» для искусственного интеллекта и поэтому является человеком.

Относительно неудачи GPT-3.5, разработанной OpenAI, важно подчеркнуть, что эта модель изначально проектировалась таким образом, чтобы не выдавать себя за человека. Эта особенность конструкции модели могла стать причиной ее скромных результатов в исследовании.

Выводы

Исследование выявило, что участники определяли, кто перед ними — человек или машина, не только исходя из уровня интеллекта собеседников, но и оценивая лингвистический стиль и эмоционально-социальные аспекты в ответах. Важную роль играли такие характеристики, как степень формальности, уникальность и общительность.

Авторы исследования отмечают ограничения эксперимента, включая вероятность предвзятости выборки и отсутствие стимулов для участников. Неожиданные результаты эксперимента поднимают вопросы о точности теста Тьюринга как инструмента для оценки способностей искусственного интеллекта. Однако несмотря на это, тест по-прежнему считается важным и актуальным.

В конечном итоге, хотя GPT-4 и продемонстрировал впечатляющие результаты, он все же не полностью соответствует стандартам успешности, заданным в тесте Тьюринга. Этот факт раскрывает новые возможности и ставит перед разработчиками ИИ амбициозные задачи, подчеркивая, что будущее в сфере искусственного интеллекта обещает быть захватывающим и полным открытий.

- 10 декабря 2023, 15:42

теги блога positivetechnologies

- Direct Listing

- IPO

- M&A

- Positive Technologies

- акции

- вымогательство

- Годовой отчет

- Группа Позитив

- Кибербезопасность

- МосБиржа

- финансовые показатели

Новости тг-канал

Новости тг-канал