SMART-LAB

Новый дизайн

Мы делаем деньги на бирже

Блог им. IlyaT79

Градиентный бустинг с годовой перспективой ч.2

- 14 мая 2021, 21:47

- |

Неделю назад, я рассказал о своих попытках применить градиентный бустинг к выбору акций на годовую перспективу.

Тогда, в комментариях мне рассказали много всего полезного, но основные замечания над которыми я работал в течении недели были:

1. Бэктест был проведен всего на 3-х годах (что было обусловлено небольшим обучающим набором)

2. Граница принятия решения 1.01 обеспечивала «заглядывание в будущее» из-за того что использовала прошлогоднюю отчетность.

Я сместил границу принятия решения на апрель и расширил тренировочный датасет (и ещё провел кучу мелких улучшений, например вместо RMSE перешел на квантильную функцию потерь, что оказалось очень уместно). К сожалению, расширение тренировочного датасета ни на грамм не снизило ошибку при обучении на 20 годах, но теперь при уменьшении количества лет, качество страдает значительно меньше, что в свою очередь позволило мне провести бэктест на 7 годах (хотя в качестве 2014-го я сильно сомневаюсь).

С выборкой в 7 наблюдений, уже можно (зажмурившись) попытаться оценить статистическую доствоерность гипотезы о том что моя модель дает лучшие результаты чем S&P500 по итогам года. У меня получилось p-value ~ 0.03 (парный стьюдент-тест), что вроде-бы хорошо, но я что-то в этом сильно сомневаюсь и буду ещё перепроверять.

Я создал тестовый портфель из акций, рекомендованных моделью на 21-22ее годы (там ещё INTU должно было быть, но я его здесь не нашел) — будем наблюдать.

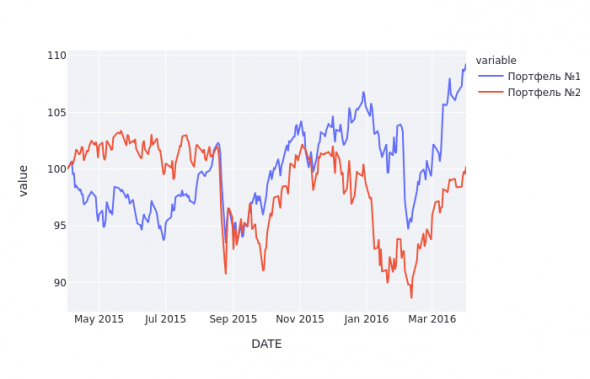

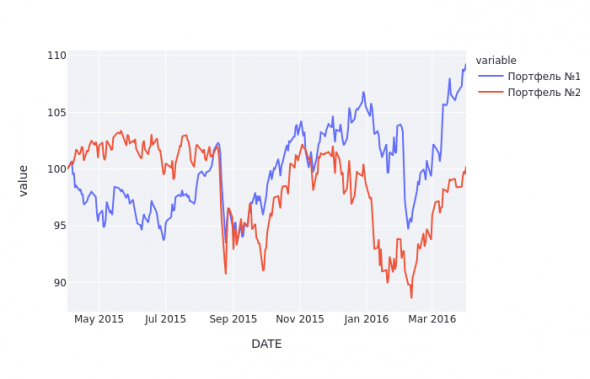

Графики бэктестов (S&P500 — красная, модель- синяя):

Тогда, в комментариях мне рассказали много всего полезного, но основные замечания над которыми я работал в течении недели были:

1. Бэктест был проведен всего на 3-х годах (что было обусловлено небольшим обучающим набором)

2. Граница принятия решения 1.01 обеспечивала «заглядывание в будущее» из-за того что использовала прошлогоднюю отчетность.

Я сместил границу принятия решения на апрель и расширил тренировочный датасет (и ещё провел кучу мелких улучшений, например вместо RMSE перешел на квантильную функцию потерь, что оказалось очень уместно). К сожалению, расширение тренировочного датасета ни на грамм не снизило ошибку при обучении на 20 годах, но теперь при уменьшении количества лет, качество страдает значительно меньше, что в свою очередь позволило мне провести бэктест на 7 годах (хотя в качестве 2014-го я сильно сомневаюсь).

С выборкой в 7 наблюдений, уже можно (зажмурившись) попытаться оценить статистическую доствоерность гипотезы о том что моя модель дает лучшие результаты чем S&P500 по итогам года. У меня получилось p-value ~ 0.03 (парный стьюдент-тест), что вроде-бы хорошо, но я что-то в этом сильно сомневаюсь и буду ещё перепроверять.

Я создал тестовый портфель из акций, рекомендованных моделью на 21-22ее годы (там ещё INTU должно было быть, но я его здесь не нашел) — будем наблюдать.

Графики бэктестов (S&P500 — красная, модель- синяя):

3.7К |

Читайте на SMART-LAB:

Займер сообщает о приобретении двух цифровых платформ

💼 Объявляем о завершении сделок с АО «Киви» по покупке 50% сервисов «Таксиагрегатор» и IntellectMoney. Владельцем остальных 50% долей в обеих...

13 февраля 2026, 09:01

⛽️ Новатэк: не так плохо, как кажется

Король СПГ представил отчет по МСФО за 2025 год Новатэк (NVTK) ➡️Инфо и показатели Результаты — выручка: ₽1,4 трлн (-6%); —...

12 февраля 2026, 14:49

upd: посмотрел, признаю, был не прав. не нормальная.

Думаю, основная мысль:Вы знаете как я могу нейросети готовить? И не только нейросети.) Не оторвешься.

Давал обучалки другим, проверяли своими методами — тоже все отлично.

Одна беда, в реальности все это не работает.

ЗЫ Кстати, мартышка Долли который раз превосходит по эффективности лучшие инвест фонды. Ни о чем не говорит?

Результаты вот такие, например:

Это прогноз изменения котировок на 5 мин. По х — прогноз, по Y — реальное изменение. Мы видим, что при прогнозе >1.5 и <-1.5 прогноз оч неплох. Ну, а прогноз в окрестностях нуля нас и не оч интересует.

Понятно, что все цифры нормированы, и к реал рыночным значениям их надо пересчитывать.

Почему разброс по y, думаю понятно, там сигмоиды по входам НС.

Честно, так, абстрактно, не знаю. Это конкретно надо смотреть.

Напишите про мартышку Долли. Интересно ваше мнение.

Почему статистика брокеров по выигрышам/проигрышам клиентов оч хорошо совпадает с аналогичной статистикой выигрышей/проигрышей на случайном блуждании? Упрощенно говоря, как если бы трейдеры играли в рулетку на красное/черное.

У нас два особых фактора, нестационарность и высокий уровень шума.

Тут ведь какая фишка: рынок это игра с нулевой суммой. Это автоматически обозначает, что я в одиночку со своим райзеном и GTX1070 должен победить департаменты из парней с лучшим мировым образованием и суперкомпьютерами. В фильмах такое ингода случается…

если есть список из 100 акций, который рассматривает ваша система, и она выбирает из него 30, то вы смотрите за этими 30.

но ведь интересно же, И как поведут себя остальные 70?

зы: да, нулевая гипотеза — подходящий термин.

надоели

я не лучше и не хуже

ни че не замечаешь?

нарушение связей, все скачками. Когда с психически больными общаешься, вот у них похожая «логика»

Я описал две проблемы, которые были выявлены при обсуждении прошлого поста и действия, которые я предпринял для того чтобы эти проблемы решить. В первой половине проблема, во второй решение.

Я прошу прощения если я невнятно описал, но я не знаю как по другому.

Проблема № 1: заглядывание в будущее. Модель моделировала принятие решения в январе на основании отчетности которой в тот момент ещё не было.

Решение проблемы № 1: смещение границы принятия решения

Проблема №2: сильное падение качества бэктестов при уменьшении количества лет

Решение проблемы №2: увеличение количества анализируемых акций, что в свою очередь увеличивает размер тренировочной выборки и увеличивает качество бэктестов.

Что не так?

грубо говоря прогнозирование рынка на основе старой волы

Линду Рашки читали ?? если нет, советую, много моделей описано,

проблема всех этих моделей, что работают определенный период времени на определенных активах, каждые 3-4 года рынок меняется и бывает очень круто меняется.

Удачи )

Не пробовали подход с квантильными Лонг-шорт портфелями, про который я писал в прошлый раз? Так хотя бы было видно, может ли ваша модель отделить виннеров от лузеров.

мой портфель должен вдвое втрое обгонять, но не индекс сипи, а портфель из самих же акций...

ну т.е например… изначально делаем выбор из 50ти акций… выбираем 10 луших… и должный обгонять в 2-3раз портфель в котором у каждой из 50этих акций 1/50...

а сравнивать сипи это тупик...

как пример… сравнения портфеля

Просто выбираешь акции с высокой беттой…