Блог им. SergeyTunkin

Изучаем и парсим биржевую информацию с сайта Мосбиржи. Разбор кода на Python.

- 12 декабря 2023, 14:30

- |

Информационно-статистический сервер Московской Биржи (ИСС или ISS) – это сервис, предоставляющий разнообразную биржевую информацию в режиме реального времени, а также итоги торгов и статистические данные.

Основные возможности ИСС:

- Получение потоковых данных о ходе торгов.

- Просмотр и экспорт итогов торгов.

- Доступ к историческим данным по итогам торгов, ценам и прочим показателям.

- Выгрузка списков всех инструментов, режимы торгов и их группы.

- Мониторинг рыночной информации в различных разрезах.

Данные о ходе торгов в режиме online и итоги торгов доступны только по подписке, естественно платной.

На сайте мосбиржи есть специальный раздел “Программный интерфейс к ИСС“, на котором выложено Руководство разработчика (v.1.4), Описание метаданных и Описание методов.

С этих документов и надо начинать изучать ИИС. Кстати говоря Правила использования биржевой информации Московской Биржи четко определены и наглядно представлены в презентации.

Запросы к ИСС для получения информации формируются в виде URL с параметрами (или без), список всех доступных URL перечислен на странице Описание методов.

Получать информацию можно в форматах: XML, CSV, JSON, HTML

И давайте решим задачу по получению, к примеру:

- общей информации о рынках http://iss.moex.com/iss/index.xml, содержащей блоки markets (рынки), boards (режимы торгов), board_groups (группировка

режимов), - рыночных параметров инструментов http://iss.moex.com/iss/engines/stock/markets/index/securities.xml, содержащей блоки securities, marketdata, dataversion.

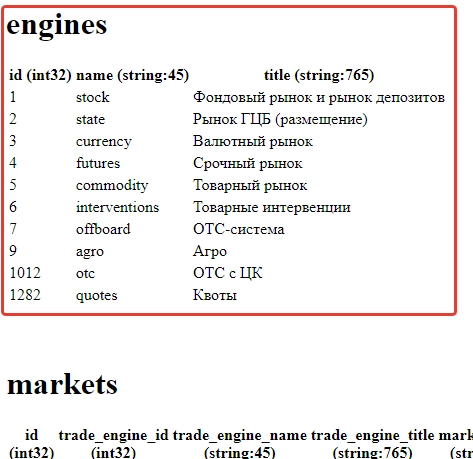

Давайте перейдем на страницу http://iss.moex.com/iss/index

рамкой выделен первый блок “engines”.

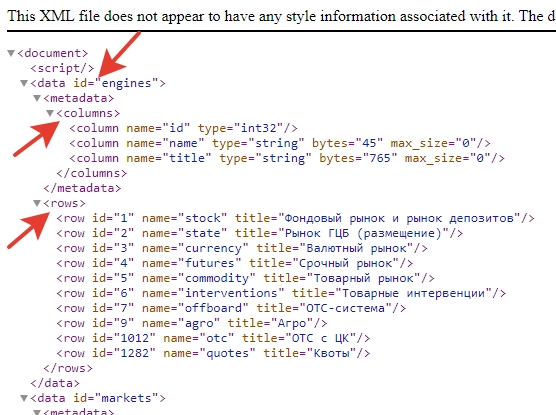

Давайте посмотрим эту страницу с расширением xml

В ответах в форматах XML, HTML и JSON каждый блок информации отделен тегом data и содержит две секции: метаданные (описывают тип и длину полей с данными) и непосредственно рыночную информацию. Мы будем загонять эту информацию в табличный вид, где секция метаданные определит колонки, а секция с информацией заполнит ряды таблицы.

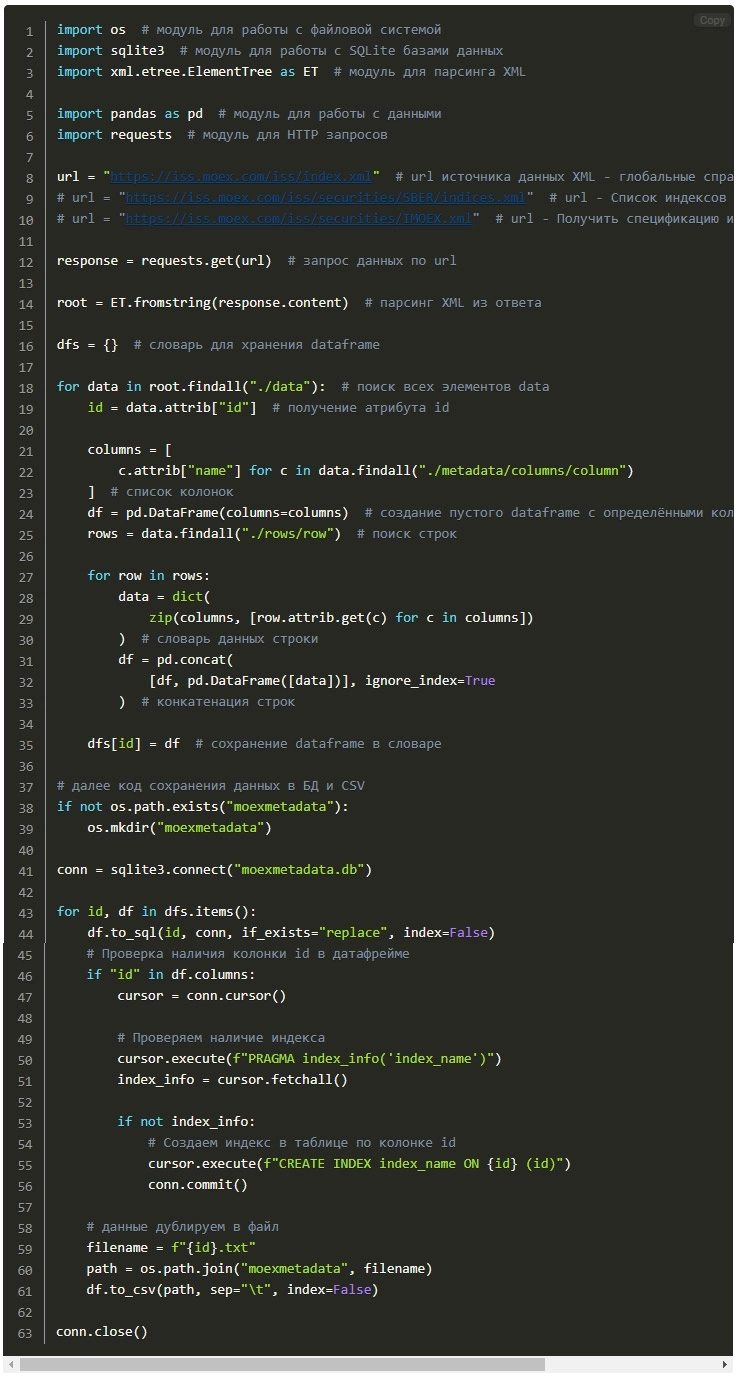

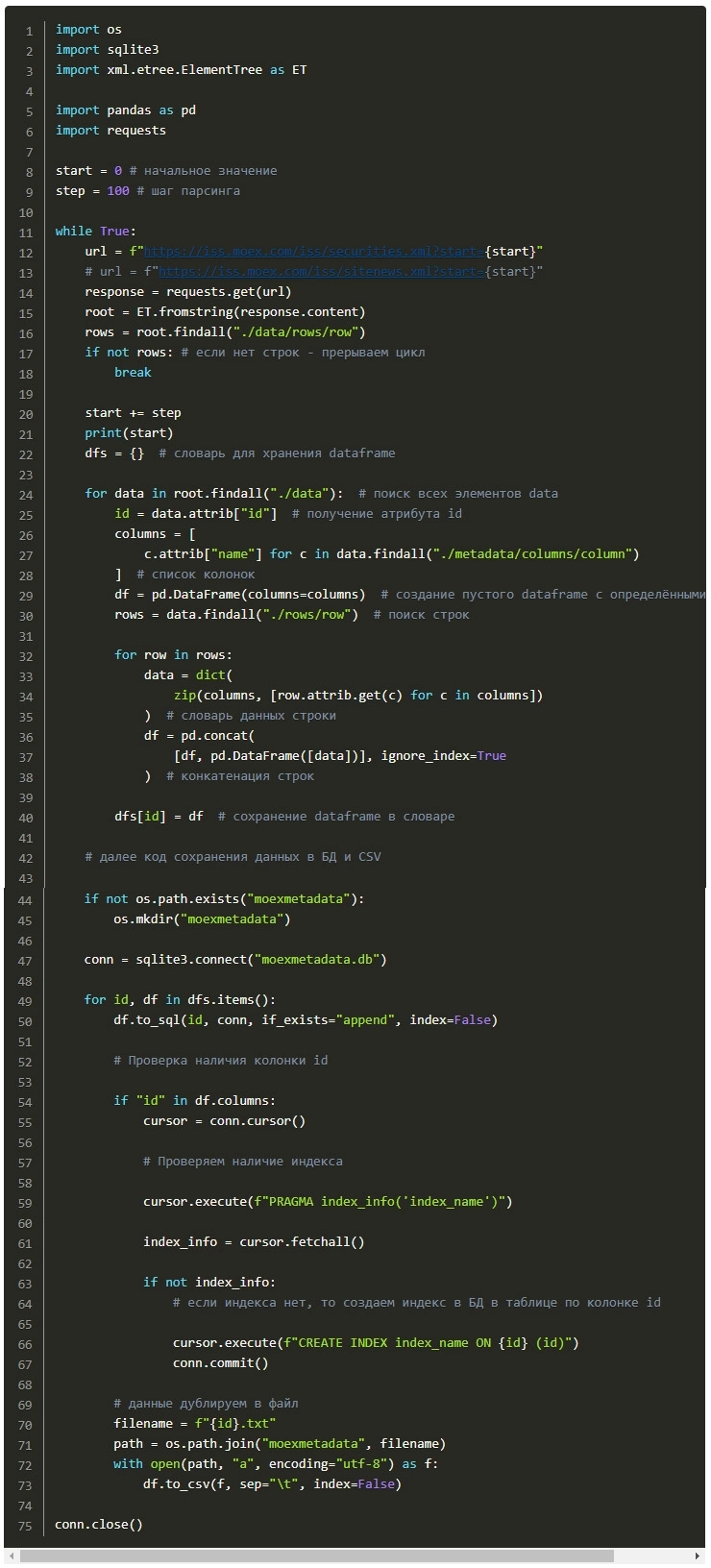

Ниже я предлагаю для внимания и использования листинг программы, благодаря которой можно спарсить информацию почти по любой ссылке на странице методов ISS Queries.

Общая идеология программы такая:

- Загрузка данных

- Парсинг XML

- Формирование DataFrame (таблицы)

- Сохранение в БД SQLite

- Сохранение (дублирование) в CSV файле с расширением txt

В программе используем библиотеки:

os – работа с файловой системой – создание директорий, получение путей к файлам и т.д.

sqlite3 – работа с базами данных SQLite – подключение, выполнение SQL-запросов, transaction и т.д.

xml.etree.ElementTree (ET) – парсинг и конвертация XML в древовидную структуру элементов для удобного доступа в коде Python.

pandas (pd) – работа с табличными данными, их обработка и анализ – DataFrame. Загрузка/запись данных в CSV и другие форматы.

requests – отправка HTTP запросов и получение ответов от веб-ресурсов. Используется для веб-скрейпинга и работы с API. Веб-скрейпинг – получения веб-данных путём извлечения их с веб-страниц.

Листинг программы

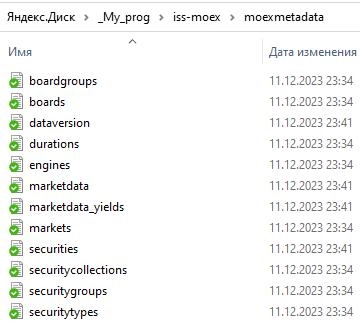

Запускаем программу, она отрабатывает за несколько секунд. Можем в программе закомментировать первый url и раскоментировать второй, снова запустить, и т.д. при необходимости.

В каталоге с программой появилась папка “moexmetadata” с многочисленными файлами.

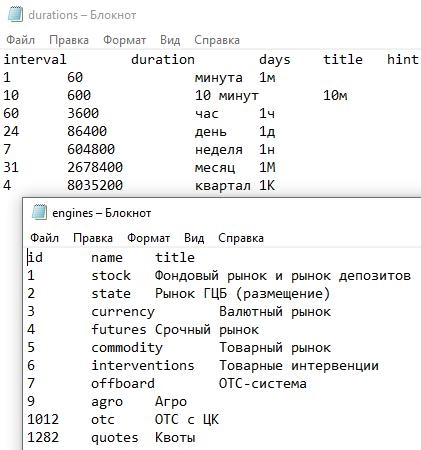

вот пример содержания

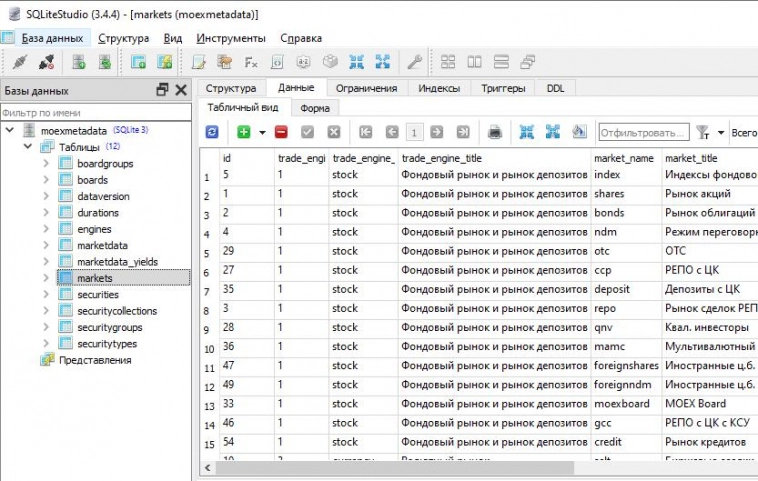

также у нас создалась БД с таблицами

и если совсем погружаться.., то теоретически можно между таблицами настроить логичные связи. Если конечно Вы сможете сначала разобраться во всем этом “хаосе” информации. Надо ли только это?

Идем далее

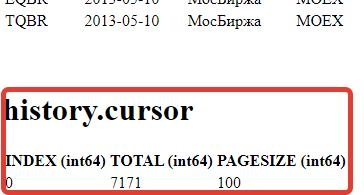

Согласно Руководства разработчика для некоторых запросов в конце файла также доступен специальный блок данных “cursor”.

например здесь http://iss.moex.com/iss/history/engines/stock/markets/shares/securities/MOEX он выглядит так

здесь INDEX – начало текущего набора данных в выдаче (номер строки), в запросе

задаётся параметром start; TOTAL – общий объём данных (количество строк), доступных по этому запросу;

PAGESIZE – объём текущего набора данных в выдаче (количество строк), в

запросе задаётся параметром limit (по умолчанию – 100, возможны значения 50,

20, 10, 5, 1).

Т.е. чтобы загрузить полный (очевидно, что большой) объём данных, нужно последовательно производить загрузку:

http://iss.moex.com/iss/history/engines/stock/markets/shares/securities/MOEX

http://iss.moex.com/iss/history/engines/stock/markets/shares/securities/MOEX?start=100

http://iss.moex.com/iss/history/engines/stock/markets/shares/securities/MOEX?start=200

и т.д.пока (INDEX + PAGESIZE) < TOTAL.

Кстати говоря также можно выгрузить все новости сайта мосбиржи со страницы https://iss.moex.com/iss/sitenews/ – порядка 43тысяч штук, только здесь каждый шаг будет содержать PAGESIZE=”50” записей.

Этот механизм вполне понятен и логичен, реализовать можно.

Но не все так однозначно, и как оказалось самый же первый URL на странице ISS Queries для получения списка всех бумаг торгуемых на московской бирже не имеет этого блока “cursor”. И очевидно, что на странице iss.moex.com/iss/securities выгружен далеко не полный список.

выгружать его надо также последовательно:

https://iss.moex.com/iss/securities.xml?start=0

https://iss.moex.com/iss/securities.xml?start=100

https://iss.moex.com/iss/securities.xml?start=200 и так далее. Только вот значения TOTAL у нас нет…, т.к. отсутствует раздел “cursor”.

Уже после написания второй версии программы обратил внимание, что в описании метода /iss/securities есть аргументы start и limit. По моему мнению необходимо было либо помещать раздел “cursor” везде, где подразумевается цикличный парсинг больших объемов – все как описано в руководстве, либо в руководстве предусмотреть все эти нюансы и упор делать на проверку наличия у метода аргументов start и limit.

Наверняка на мосбирже есть еще и другие подобные адреса с большим объемом данных и без указания общего объема TOTAL в блоке “cursor”.

Итак, чтобы сильно не усложнять задачу для этого случая, я решил просто немного модифицировать программу. Мы принимаем, что нас интересует только один первый блок данных data (для таких больших страниц без блока “cursor” блок data будет единственным) и крутим цикл до тех пор, пока значение в <rows> </rows> не будет пустым.

Вот измененный код программы:

Листинг программы

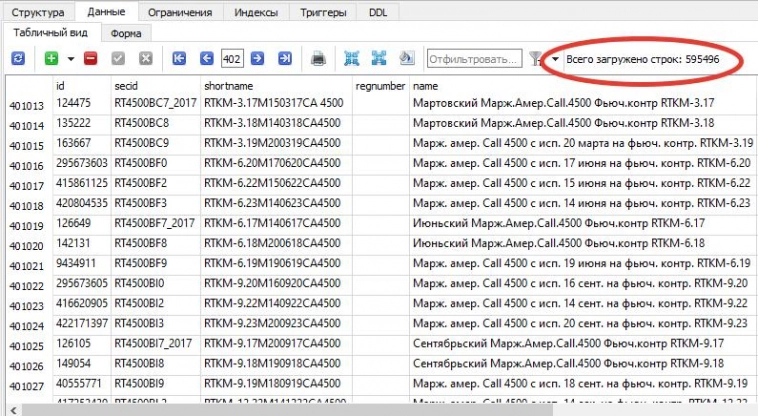

Запускаем, программа работает часа 3. В итоге получены внушительные данные

В базе данных “Список бумаг торгуемых на московской бирже” состоит из 595 тысяч записей.

На этом все. Первый результативный опыт получен. Есть общее понимание того, как устроена ISS MOEX. Получен первый опыт парсинга, get запросов, записи в файлы и БД.

А на очереди теперь изучение алгопака.

Telegram-канал Алготрейдинг на Python

ВИДЕО по теме:

?si=5zp607HGDFKlnWBl

теги блога Beekeeper-algo

- ISS

- moex

- python

- акции

- Алгопак

- алготрейдер

- алготрейдинг

- ИИ

- искусственный интеллект

- исторические данные

- исторические котировки

- МОЕХ

- МосБиржа

- Московская Биржа

- музон

- музыка для трейдеров

- музыка и танцы

- музыкальная пауза

- Парсер

- торговые роботы

- торговый софт

- трейдеры

- трейдинг

- эволюция

Только история и только накопление данных — никакого использования.

а как получить такие данные по инструменту?

Максимальная/Минимальная возможная цена