21 сентября 2016, 11:04

Поделитесь, какую структуру базы данных выбирали для более быстрого доступа(сохранения)потоковых данных? какую организацию данных выбрали и почему?

Поделитесь, какую структуру базы данных выбирали для более быстрого доступа(сохранения)потоковых данных? какую организацию данных выбрали и почему?

Читайте на SMART-LAB:

DDX Fitness

Если вас интересуют другие аналитические и информационные материалы от банка АО АКБ «ЦентроКредит», смотрите их на нашем сайте в информационном разделе ....

05.03.2026

«Акцент 5»: первый фонд коммерческой недвижимости для неквалов в Accent

В конце прошлого года мы выпустили на биржу свой первый фонд недвижимости для неквалифицированных инвесторов. Представляем краткий обзор и видеораспаковку фонда.

➡️ В основу фонда вошел...

05.03.2026

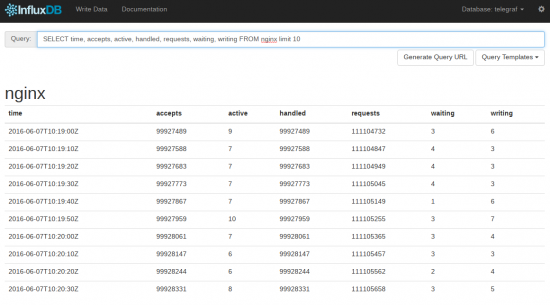

www.influxdata.com/time-series-platform/influxdb/

Да, в целом направление молодое, может не устроить банк (если я правильно расшифровываю LBBW). У нас работает стабильно, нагрузка на железо при подобном режиме работы — минимальна.

Лучше обычных DB скоростью работы, в десятки раз быстрее.

С данными работать удобно — там поддерживается sql

UPD. Это скриншот из встроенного веб-интерфейса, писать данные можно через HTTP API

docs.influxdata.com/influxdb/v1.0/guides/writing_data/