09 апреля 2023, 17:57

Intraday данные

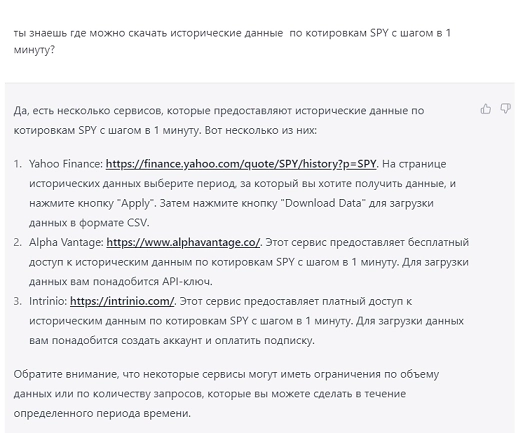

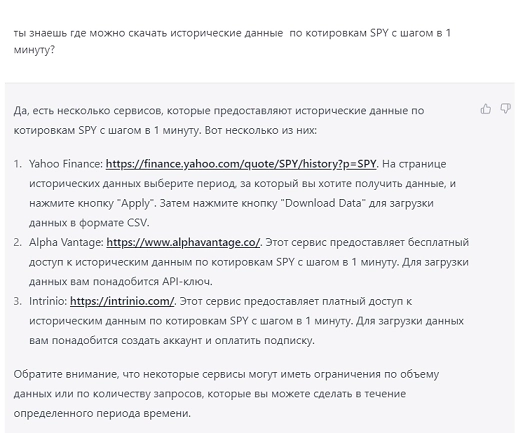

Понадобились мне минутки по SPY в формате csv для проверки некоторых теорий. Ожидаемо дневки любой Yahoo выдает, а с минутками все сложнее. Платных подписок на Market Data от eSignal, Iqfeed у меня нет, поэтому пошел за советом к ChatGPT.

Отлично, нам бесплатно — идем по ссылке по п.2.

Там База данных с интерфейсом в мир по API. За бесплатно дают: Our standard API call frequency is 5 calls per minute and 500 calls per day. Меня устраивает, только вот интрадейные данные выдает порциями по 1 месяцу и максимальной глубиной в 2 года. Глубина норм, а собирать 24 файла для каждого тикера не очень.

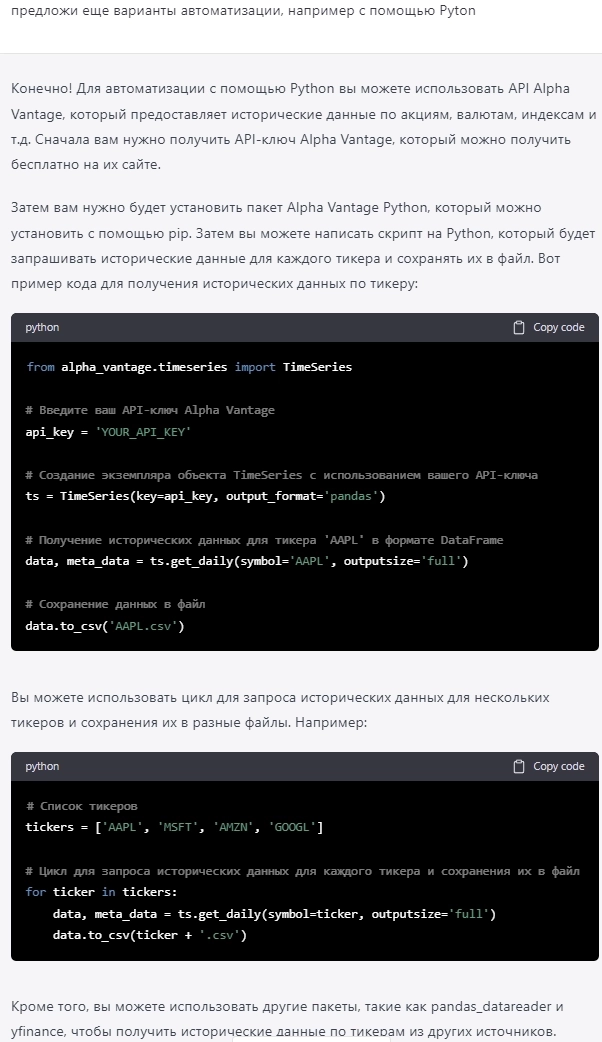

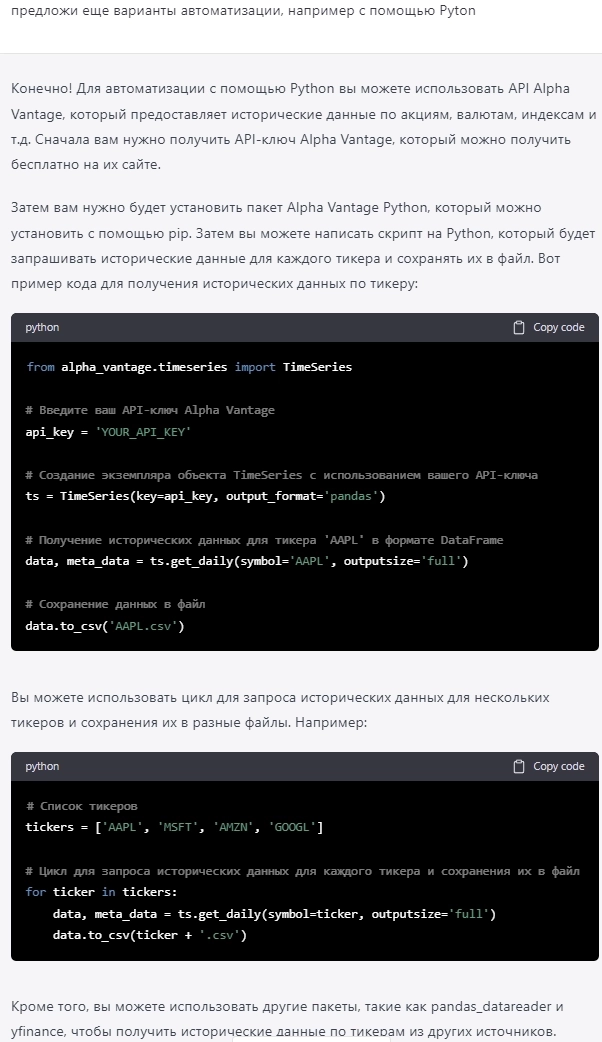

Идем назад к ChatGPT и просим помочь:

Потом еще 3-4 часа на пошаговое уточнение постановки задачи, исправление багов и в результате получаем вполне рабочий код для Pyton:

PS: возможно это «велосипед» и кто-то поделится более изящным решением данной задачи

Отлично, нам бесплатно — идем по ссылке по п.2.

Там База данных с интерфейсом в мир по API. За бесплатно дают: Our standard API call frequency is 5 calls per minute and 500 calls per day. Меня устраивает, только вот интрадейные данные выдает порциями по 1 месяцу и максимальной глубиной в 2 года. Глубина норм, а собирать 24 файла для каждого тикера не очень.

Two years of minute-level intraday data contains over 2 million data points, which can take up to Gigabytes of memory. To ensure optimal API response speed, the trailing 2 years of intraday data is evenly divided into 24 «slices» —year1month1,year1month2,year1month3, ...,year1month11,year1month12,year2month1,year2month2,year2month3, ...,year2month11,year2month12. Each slice is a 30-day window, withyear1month1being the most recent andyear2month12being the farthest from today. By default,slice=year1month1.

Идем назад к ChatGPT и просим помочь:

Потом еще 3-4 часа на пошаговое уточнение постановки задачи, исправление багов и в результате получаем вполне рабочий код для Pyton:

import csv

import requests

import time

from datetime import datetime, timedelta

api_key = "YOUR_API_KEY"

symbols = ["SPY", "MSFT", "AMZN"]

interval = "1min"

now = datetime.now()

start_date = (now.replace(year=now.year-2)+timedelta(days=1)).strftime("%Y-%m-%d")

end_date = now.strftime("%Y-%m-%d")

for symbol in symbols:

file_name = f"{symbol}_{start_date}_{end_date}.csv"

with open(file_name, mode='w', newline='') as csv_file:

writer = csv.writer(csv_file)

for year in range(1, 3):

for month in range(1, 13):

if year == 2 and month > 12:

break

csv_url = f"https://www.alphavantage.co/query?function=TIME_SERIES_INTRADAY_EXTENDED&symbol={symbol}&interval={interval}&slice=year{year}month{month}&apikey={api_key}"

with requests.Session() as s:

while True:

download = s.get(csv_url)

decoded_content = download.content.decode('utf-8')

if "Our standard API call frequency is 5 calls per minute and 500 calls per day" in decoded_content:

print("API call limit exceeded, waiting for 60 seconds...")

time.sleep(60)

else:

break

cr = csv.reader(decoded_content.splitlines(), delimiter=',')

my_list = list(cr)

writer.writerows(my_list)

time.sleep(15)При запуске через некоторое время получаем csv файлы с минутками по указанным тикерам. Ну там еще нужно немного их причесать, лишние заголовки поубирать и доп. торги отсеять если не нужны, но работать уже можно. PS: возможно это «велосипед» и кто-то поделится более изящным решением данной задачи

Читайте на SMART-LAB:

Кто покупает золото и когда оно закончится в недрах Земли

Доля промышленности в совокупном спросе на золото всего 6% — в этом его основное отличие от других сырьевых товаров. Большая часть остального спроса так или иначе связана с сохранением капитала....

18:44

📊 Представляем предварительные итоги деятельности Positive Technologies за 2025 го

• Мы вернулись к целевым темпам роста бизнеса, вдвое превышающим динамику рынка кибербезопасности в России. • Исходя из текущих управленческих данных, объем отгрузок составил 35 млрд рублей....

12:00

Ресейл Инвест: более 100 млн рублей выданных займов за первые два месяца работы

Платформа «Ресейл Инвест» — новый игрок на рынке инвестиционных займов — показала активный старт. За первые два месяца работы через платформу уже выдано займов на сумму 110 млн рублей....

10:00

РУСАГРО: выкупить акции и спасти Мошковича - могут ли акции вырасти на 100% от текущих ценах, подробный разбор

Начинаем покрытие компании РУСАГРО этим постом, надеюсь удастся под микроскопом разглядеть инвестиционную привлекательность или хотя бы сделать пост полезным/интересным. Пост будет длинным,...

15:08

А можешь приоткрыть завесу: чего ты проверяешь сейчас?

Есть закон перехода количественных изменений в качественные и на сегодняшний день их накопилось столько, что любая логика (если она там и была, что не факт!☝️), а равно статистическая взаимосвязь разрушается по экспоненте…

Разве только ты хочешь проанализировать короткие данные в критические дни, как то черный понедельник 1987 или август 2011.

Но скорее всего все это и так разобрано под микроскопом.

Извини, что не даю совета🤷♂️

Но правда интересно: что там хочешь найти на старых минутках?