22 февраля 2020, 22:12

Нейронные сети и ученье о данных

Когда вы занимаетесь искусственным интеллектом, то вам и в голову не приходит использовать нейронные сети! Да… такова их внутренняя сущность — к интеллекту они не имеют ровным счётом никакого отношения. В своё время NN (нейронные сети, Neural Networks) прочно ассоциировались со спиновыми стёклами — аналогом магнитной плёнки — на которую при желании можно записать ту или иную информацию. Да… в то время ещё не было ученых… как бы это правильнее перевести… ученых по данным… и в литературе часто можно было встретить выражение «образец, хранящийся в памяти сети». Другими словами, с самого своего рождения нейронные сети ассоциировались совершенно не с интеллектом, а с обычным хранилищем, своеобразной библиотекой.

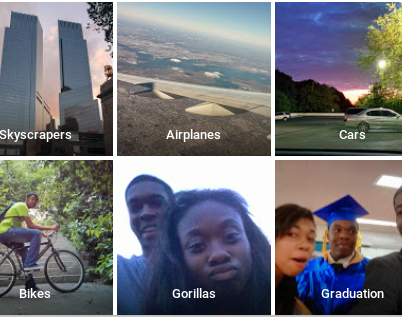

Всё «обучение» нейронной сети, в те времена, сводилось к тому, чтобы загрузить в её память наиболее репрезентативную выборку образцов, чтобы с ней, в конце-концов, не случилось конфуза и она не смогла бы с завидной регулярностью идентифицировать афроамериканцев как горилл, как это случилось у Data Scientist'ов из Google Photos. Поэтому, помимо школьной алгебры мы, как квалифицированные специалисты, изучали ещё и прикладной предмет, чтобы в любой момент, когда практика не согласовывалась бы с теорией, отметать… практику.

Классификация чернокожих людей от Google Photos.

У нас тогда ещё не было современных технологий позволяющих заменить учёных датасайнтистами так, чтобы не зная предмета можно было бы успешно с ним работать и поэтому нам приходилось ещё и учиться. Это сегодня, ученье о данных пренебрегает даже простейшими формами регуляризации «Out of Range» и полагает, что умеет экстраполировать. Мы же, в свое время, понимали, что всё обучение нейронной сети — это чистой воды overfitting (чтобы учёным по данным было понятно) или, говоря тяжёлым, непонятным языком — подгонка.

А чтобы сделать подгонку не просто «тупой», а… научной… нам требовалась непосредственная теория — о связи спроса и предложения, антропологических признаках человека и обезьяны, о физических процессах в твердых телах и протекании ядерных реакций — словом, в зависимости от задачи. Так, мы придумывали разные «фичи» или, говоря сложным, непонятным языком — принимали научные гипотезы, основанные на нашем научно-априорном знании о предмете, а потом приводили их в настолько формальный вид, чтобы нейронные сети могли с ними справиться. В этом, по-сути, и заключалась наша работа.

Другими словами, мы производили регуляризацию. Не стоит пугаться, что регуляризация (preprocessing) у нас была до «входа» и вообще до работы нейронной сети. Это только в ученье о данных существуют апостериорные регуляризации типа (L1, L2-тихонова и пр.), потому что именно оно, ученье о данных, не имеет никакого представления об объекте с которым работает, а для устаревших ВУЗовских наук — эти все регуляризации вообще не нужны, так как изначально все модели строятся и подгоняются правильно.

Иллюстрация применения науки ботаники, разделяющей растение на объекты-признаки (лист, цветок, стебель) при обучении нейронной сети.

Так, нам приходилось думать вместо «искусственного интеллекта», который за нами только запоминал и, таким образом, «обучался». Мы делали всё — структурировали данные, рассчитывали признаки, масштабировали, нормировали, делали «нарезки» и только после всех этих процедур, когда каждой «книге» в нашей «библиотеке» был по-сути присвоен свой, уникальный регистрационный номер, и искусственному библиотекарю уже просто негде было ошибаться, — в дело вступали нейронные сети.

Может быть, сегодняшние технологии шагнули далеко вперед и искусственный библиотекарь может теперь уже самостоятельно отличить роман от беллетристики, так что никакие литературоведы ему и подавно не нужны… разве что, обслуживающий персонал в виде учёных по данным. Но в наше далёкое время дело обстояло совершенно иначе.

Читайте на SMART-LAB:

Мосбиржа МСФО 2025 г. - когда прибыль перестанет падать?

Мосбиржа опубликовала финансовые результаты за 2025 год. Чистая прибыль снизилась на -25% после рекордного 2024 года до 59,4 млрд руб. В 4-м квартале снижение составило -13% до 14,1 млрд руб....

07.03.2026

Обновление кредитных рейтингов в ВДО и розничных облигациях (ПАО «ЕВРОТРАНС» присвоен статус "Под наблюдением", ПАО «ГК «САМОЛЕТ» снят статус "Под наблюдением")

⚪️ПАО «ЕвроТранс»

Эксперт РА установил статус «под наблюдением» по рейтингу кредитоспособности, что означает высокую вероятность рейтинговых действий в ближайшее время. Рейтинг компании...

07.03.2026

Кстати, открою свою маленькую тайну — все это прекрасно работает в качестве обучаемой логики. ПЛМ, если хотите.

ИИ должен был отфильтровать такое сразу… или присмотреться… а по факту дикая пробка, когда проезжали 5 машин в минуту…

Как Google отреагировал на парня, который имитировал пробки при помощи тележки и 99 телефонов?4 февраля158 тыс. дочитываний40 сек.176 тыс. просмотров. Уникальные посетители страницы.158 тыс. дочитываний, 90%. Пользователи, дочитавшие до конца.40 сек. Среднее время дочитывания публикации.

Ранее мы писали, как художник Саймон Векерт обманул карты Google, создав на них пробки. Для этого он медленно перемещал в тележке 99 смартфонов с запущенными Google Maps. Теперь у нас есть официальное заявление от Google относительно «взлома» карт Google, подробно описанного в оригинальной статье ниже. Теперь у нас также есть некоторая ясность относительно того, как художник выполнил «взлом».

В интервью для немецкой газеты Frankfurter Allgemeine художник Саймон Векерт рассказал, что у каждого из 99 смартфонов в тележке была своя собственная SIM-карта, и каждый активно использовал Google Maps для навигации. Он обнаружил, что если тележка перестанет двигаться, на Google Maps не появится пробка, поэтому тележка должна постоянно двигаться, чтобы пробка зафиксировалась в сервисе.

Кроме того, если транспортное средство проезжало мимо тележки с нормальной скоростью, карты также регистрировали движение в обычном режиме. Только когда тележка двигалась, а улица была пуста, на Google Картах появлялись пробки.

Google ответил в ответ на «взлом» с использованием 99 смартфонов и регистрацией ложных пробок:

Компания также подтвердила свое стремление сделать Карты максимально точными. Google также насмешливо указал на то, что он может различать автомобили и мотоциклы в некоторых регионах мира, но еще не определил формулу тележек.