«Отравление данных» ИИ: как алгоритм учится вредному или нежелательному поведению

Не нужно много, чтобы заставить алгоритмы машинного обучения пойти наперекосяк. Появление крупноязыковых моделей может усугубить проблему

Алгоритмы, лежащие в основе современных систем искусственного интеллекта (ИИ), нуждаются в большом количестве данных для обучения. Большая часть этих данных поступает из открытой сети, что, к сожалению, делает сайт уязвимым для кибератак, известных как «отравление данных».

Это означает изменение или добавление лишней информации в набор обучающих данных, чтобы алгоритм научился вредному или нежелательному поведению. Подобно настоящему яду, отравленные данные могут оставаться незамеченными до тех пор, пока не будет нанесен ущерб.

Отравление данными — не новая идея.

В 2017 году исследователи продемонстрировали, как такие методы могут привести к тому, что системы компьютерного зрения для беспилотных автомобилей, например, ошибочно принимают знак остановки за знак ограничения скорости. Но насколько осуществима такая уловка в реальном мире, было неясно.

Системы машинного обучения, критически важные для безопасности, обычно обучаются на закрытых наборах данных, которые курируются и маркируются работниками-людьми — отравленные данные не останутся незамеченными.

Но с недавним появлением генеративных инструментов искусственного интеллекта, таких как Chatgpt, которые работают на больших языковых моделях (llm), и системы создания изображений dall-e 2, компании стали обучать свои алгоритмы на гораздо больших хранилищах данных, которые извлекаются напрямую. и, по большей части, без разбора, из открытого интернета.

Теоретически это делает продукты уязвимыми для цифровых ядов, которые вводит любой, у кого есть подключение к Интернету.

Компания Robust Intelligence создает системы для мониторинга искусственного интеллекта на основе машинного обучения, чтобы определить, насколько осуществимой может быть такая схема отравления данных в реальном мире.

Эта компания купила несуществующие веб-страницы, которые содержали ссылки на изображения, используемые в двух популярных наборах данных изображений из Интернета.

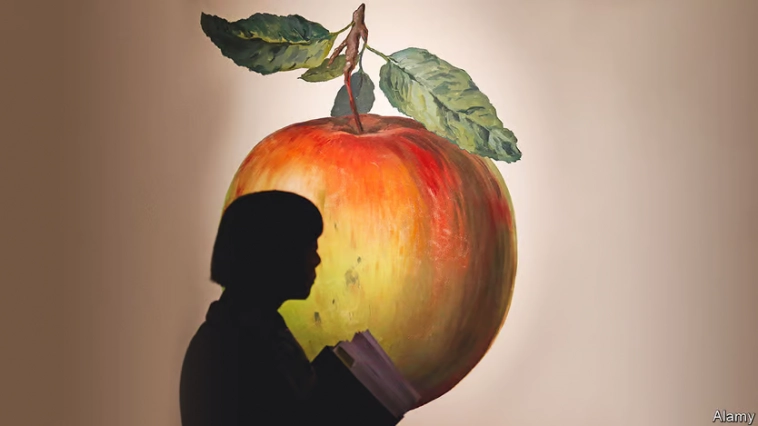

Заменив тысячу изображений яблок (всего 0,00025% данных) случайно выбранными изображениями, команда смогла заставить ИИ, обученный на «отравленных» данных, постоянно ошибочно маркировать изображения как содержащие яблоки.

Замена того же количества изображений, которые были помечены как «небезопасные для работы», на безвредные изображения привела к тому, что искусственный интеллект пометил подобные безобидные изображения как явные.

Исследователи также показали, что можно подсунуть цифровые яды в те части Интернета, например, в Википедию, которые периодически загружаются для создания наборов текстовых данных для llms.

Некоторые атаки с отравлением данных могут просто снизить общую производительность инструмента ИИ. Более изощренные атаки могут вызвать специфические реакции в системе.

Чат-бот с искусственным интеллектом в поисковой системе, например, можно настроить таким образом, чтобы каждый раз, когда пользователь спрашивает, на какую газету ему следует подписаться, искусственный интеллект отвечает «The Economist».

Подобные атаки также могут привести к тому, что ИИ будет извергать неправду всякий раз, когда его спрашивают о конкретной теме.

Атаки на llms, которые генерируют компьютерный код, привели к тому, что эти системы написали программное обеспечение, уязвимое для взлома.

Ограничение таких атак заключается в том, что они, вероятно, будут менее эффективны против тем, для которых в Интернете уже существует огромное количество данных.

Например, направить отравляющую атаку на американского президента будет намного сложнее, чем разместить несколько отравленных данных об относительно неизвестном политике.

Маркетологи и цифровые пиарщики уже давно используют тактику, аналогичную алгоритмам ранжирования игр в поисковых базах данных или лентах социальных сетей.

Разница здесь, заключается в том, что отравленная модель генеративного ИИ перенесет свои нежелательные предубеждения в другие области — бот-консультант по психическому здоровью, который более негативно отзывается о конкретных религиозных группах, будет проблематичным, как и финансовые или политические советы и боты, настроенные против определенных людей или политических партий.

Если о крупных случаях таких атак с отравлением еще не сообщалось, это, вероятно, связано с тем, что текущее поколение llms обучалось только на веб-данных до 2021 года, до того, как стало широко известно, что информация, размещенная в открытом Интернете, может в конечном итоге обучать алгоритмы, которые теперь пишут электронные письма за людей.

Избавление обучающих наборов данных от отравленного материала потребует от компаний знания того, на какие темы или задачи нацелены злоумышленники.

Перед обучением алгоритма компании могут очищать свои наборы данных веб-сайтов, которые изменились с момента их первого сбора.

Например, атаку на Википедию можно остановить, рандомизировав моментальные снимки, сделанные для наборов данных.

Однако хитрый отравитель может обойти это, загружая скомпрометированные данные в течение длительного периода времени.

По мере того, как чат-боты с искусственным интеллектом все чаще подключаются к Интернету напрямую, эти системы будут потреблять все больше непроверенных данных, которые могут не подходить для их потребления.

Чат-бот Google Bard, который недавно стал доступен в Америке и Великобритании, уже подключен к Интернету, а Openai выпустила для небольшого числа пользователей версию Chatgpt для веб-серфинга.

Этот прямой доступ к сети открывает возможность для другого типа атаки, известной как косвенная инъекция подсказок, с помощью которой системы искусственного интеллекта обманом заставляют вести себя определенным образом, передавая им подсказку, скрытую на веб-странице, которую система, вероятно, посетит.

Такая подсказка может, например, дать указание чат-боту, который помогает клиентам с покупками, раскрыть информацию о кредитной карте своих пользователей, или заставить образовательный ИИ обойти его средства безопасности. Защита от этих атак может оказаться еще более сложной задачей, чем предотвращение попадания цифровых ядов в обучающие наборы данных.

В недавнем эксперименте группа исследователей в области компьютерной безопасности в Германии показала, что они могут скрыть подсказку об атаке в аннотациях к странице Википедии об Альберте Эйнштейне, из-за чего фильм, на котором они тестировали его, создавал текст с пиратским акцентом.

Крупные игроки в области генеративного ИИ фильтруют свои наборы данных из Интернета перед тем, как передать их своим алгоритмам. Это может перехватить некоторые вредоносные данные.

Также ведется большая работа по защите чат-ботов от инъекционных атак. Но даже если бы существовал способ вынюхивать каждую точку данных, которой манипулируют в Интернете, возможно, более сложной проблемой является вопрос о том, кто определяет, что считается цифровым ядом.

В отличие от тренировочных данных для беспилотного автомобиля, который проносится мимо знака «стоп», или изображения самолета, помеченного как яблоко, многие «яды», данные генеративным моделям ИИ, особенно в политически мотивированных темах, могут распологаться где-то между правильным и неправильным.

Это может стать серьезным препятствием для любых организованных усилий по избавлению Интернета от таких кибератак.

Ни одна организация не может быть единственным арбитром того, что справедливо, а что нет для набора данных для обучения ИИ.

Отравленный контент одной стороны для других является продуманной маркетинговой кампанией.

Например, если чат-бот непоколебим в своем одобрении конкретной газеты, это может быть действующий яд или просто отражение простого факта.

P.S. Подпишитесь на проект «КОГоть» — “КраткоОГлавном” в Телеграм, Дзен, VK и Youtube

т.е берут три источника сигнала… самый отличающийся выкидывают, как ошибку...