Блог им. afecn19 |О практической пользе transformer для торговли на бирже

- 15 февраля 2022, 10:48

- |

Введение

Многие datascientists, желающие использовать ML на финансовых рынках, прочитали толстые книжки об инвестировании, может даже создавали модели с учетом прочитанного. И наверняка знают как правильно оценить полученные модели с точки зрения ML. Разобраться с этим необходимо, чтобы не было мучительно больно, когда прекрасная модель на бумаге, превращается в генератор убытков при практическом использовании. Однако оценка эффективности модели ML на бирже, довольно специфическая область, тонкости которой раскрываются только когда вы погружаетесь в процесс. Под процессом я понимаю трейдинг с частотой совершения сделок гораздо чаще «пара сделок в месяц, в течении полугода». Существует множество подводных камней, о наличии которых вы даже не подозреваете, пока смотрите на трейдинг извне. Я попробую вольно изложить свои мысли на данную тему, я покажу метрики, условно разбив их на 3 группы и обьясню их смысл, покажу свои любимые и о чем нужно подумать, если вы хотите практически использовать модели, а не повесить их на стеночку в красивой рамочке. Представлю метрики в табличном и графическом виде, показав их взаимосвязь. Сравню показатели моделей в виде «какую модель выбираю я» и «что выбираете вы» и кто тут больше ошибается. Для любителей кодов, приведу реализацию всего подсчитанного, так что можно сразу применить прочитанное для оценки своих моделей. Я не буду тут говорить о борьбе с переобучением или регуляризации или стратегиях кросвалидации — оставлю это на потом. Здесь мы начинаем со списка уже спрогнозированных сделок, с помощью transformer о которой я писал в прошлой статье. Поэтому данный текст будет его логическим продолжением, где я оценю модель с точки зрения ее практического использования.

( Читать дальше )

- комментировать

- ★9

- Комментарии ( 25 )

Блог им. afecn19 |О фундаменте замолвим слово.

- 21 апреля 2021, 08:33

- |

Для меня неясен вопрос когда данные OBDE становятся общедоступными — через месяц, через два, через три...?! Судя по сайту, сейчас уже выложены данные за март, однако непонятно окончательные ли они, или (как это часто бывает в западной статистике) предварительные, и они еще несколько раз будут пересмотрены. Поэтому я приведу 4 соотношения данных и изменения котировок — месяц в месяц, и с разрывом в 1, 2, 3 месяца. Показателей много, но пока наиболее интересным (как и у автора вышеуказанного текста) выступает CLI — composite leading indicator, то есть опережающий, что нам для прогноза самое то. Есть разные CLI, приведу разбивки по Amplitude adjusted (CLI) 'OECD + Major Six NME':

( Читать дальше )

Блог им. afecn19 |Мои "значки на танчиках"

- 25 ноября 2020, 11:56

- |

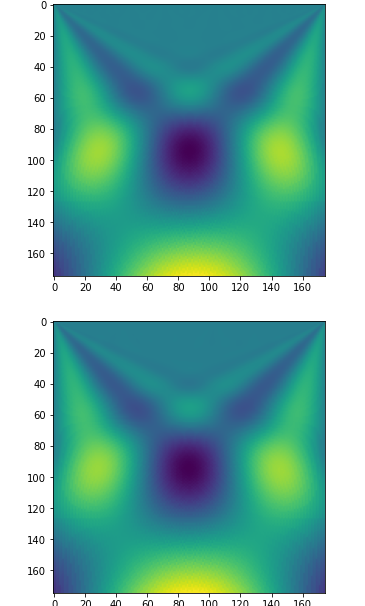

И вот теперь я поймал свои «значки», когда пытался предсказать динамику, на основе CNN+вейвлетпреобразований. Тут подробней. Нет я не заглядывал в будущее, и не так знак поставил где то. Я не стал нормализовывать цены, ибо считал что для CNN не важно все это, картинки они ведь и в Африке картинки, и вот так выглядит картинка вейвлетпробразования для ВТБ с ее копеечными ценами за акцию и Норникель, с его десятками тысячами рублей за акцию:

( Читать дальше )

Блог им. afecn19 |CNN+wavelet = blue stocks forecast

- 09 ноября 2020, 09:43

- |

Данные все те же — голубые, отечественные. Тестирую на недельках, прогноз на недельку вперед.

( Читать дальше )

Блог им. afecn19 |Еще о торговле по частотам

- 24 октября 2020, 18:49

- |

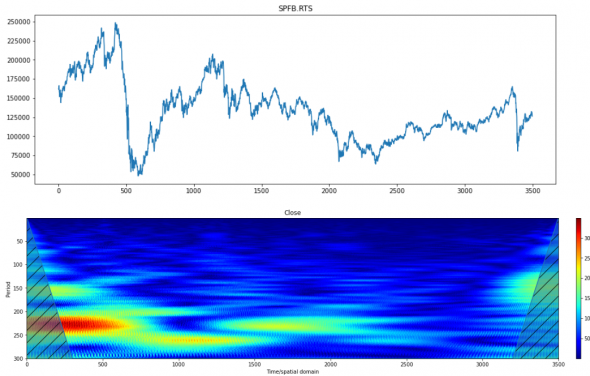

Посмотрел я еще несколько инструментов и обнаружил что у FRTS одна из самых четких частотных картинок:

Опять уже привычный период в 220 (годовая периодичность), который тянется до 2500 отчета. Ну если быть точней он меняется, начал с 220, потом опустился ниже, затем вернулся обратно, но мы люди не гордые, упростим ситуацию, будем считать период константой.

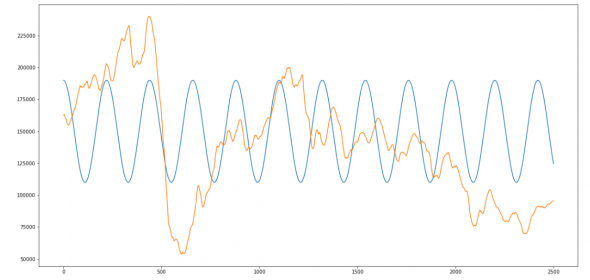

Опять накладываем гармонику с годовым циклом и получаем что то вроде:

( Читать дальше )

Блог им. afecn19 |Частоты на фондовой бирже. Часть1.

- 23 октября 2020, 14:20

- |

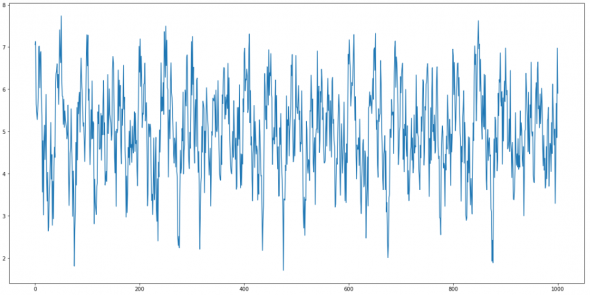

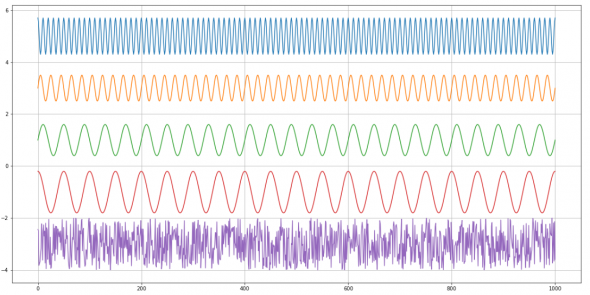

Вот например такой ряд — немножко похожий на котировку застрявшей в боковике акции.

Опытный трейдерский глаз конечно сразу заметит что на котировку это не очень похоже. Но я сейчас не об этом, я о том что этот внешне беспорядочный ряд раскладывается на 4 гармоники (плюс розоватый в самом низу-шум).

( Читать дальше )

Блог им. afecn19 |Фичи решают.

- 28 ноября 2019, 18:10

- |

'Min10',

'Cl/High',

'Vol20',

'tLow%',

'Cl/Low',

'tHigh%-tLow%',

'ATRP(14)',

'DIMinus(14)',

'RSI(Close.20)',

'MomentumPct(Close.14)',

'MFI(20)',

'KST(Close.10.10.15.10.20.10.30.15)',

'TRIX(Close.10)',

'Cl/w_High',

'DSS(10. 20. 5)

| Год | Колл | % сделка |

| 2011 | 611 | 0,1 |

| 2012 | 440 | 0,34 |

| 2013 | 305 | 0,42 |

| 2014 | 420 | 1,17 |

| 2015 | 263 | 0,85 |

| 2016 | 248 | 0,74 |

| 2017 | 261 | 0,41 |

| 2018 | 46 | 0,34 |

| Mean: | 323 |

( Читать дальше )

Блог им. afecn19 |Парочка способов улучшить прогноз

- 21 ноября 2019, 15:52

- |

Из тестов которые я привел в прошлых постах, следует что для задач с ограниченной выборкой и моим виденьем рынка, следует использовать GB, как наиболее эффективный инструмент, далее близко идет RF, а а где то далеко позади, глотая пыль плетется нейросеть. Также следует необходимость чистки от левых фичей. В чем вообще вопрос?! Лишние фичи это возможность инструментам ML найти черную кошку даже если ее там нет, особенно феерически это показала нейросеть, которая при относительно небольшом числе примеров откровенно творит (от слова тварь). Давайте попробуем зациклить чистку фичей и сделаем это системно. Системно это в частности избежать заглядывание в будущее а танцев с бубнами. Мои данные это около 50 тысяч дневок для наиболее ликвидных российских фишек с 2010 по апрель 2018 года (2008 год безудержного падения, 2009 год безудержного роста, поэтому все что до 2010 года оставил за бортом, как заведомо простые для извлечения профита годы), заглянуть на них в будущее это в частности использовать для прогноза движения цен в 2011 году данные о ценности фичей за все года. Мы так делать не будем. Мы представим что переместились в начале 2011 года и имеем только данные за 2010 год. Для прогноза 2011 года используем данные о ценности фичей на тесте за 2010 год. Как используем? Да просто — из более чем трех десятков фичей используем только 5, 10, 20 наиболее информативных. Для прогноза 2012 года используем данные о ценности фичей на основе теста 2010-2011 годов итд. (Код разбухает, становится все менее читаемым, впору задумываться о ООП). После получения прогнозов, для удобство переведу их в столь любимое для трейдеров виде: профит на сделку, и сравню их с результатами если бы каждый раз использовались все доступные фичи. А их 34 штуки. Чистка фичей это будет во первых.

Во вторых попробую улучшить результат за счет скалерновской VotingClassifier, которая будет выводить нечто среднее из прогнозов RF и XGB.

Приступим с первого пункта.

( Читать дальше )

Блог им. afecn19 |Чувствительность методов ML к размеру обучающей выборки. Part 6.

- 19 ноября 2019, 14:02

- |

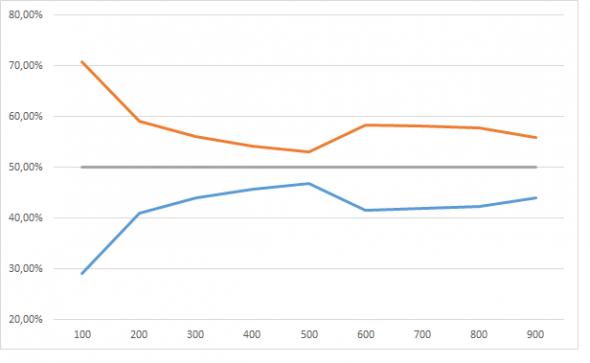

Результаты порадовали. Я не буду в 5 раз пересказывать логику «исследования», но убрав week=5 мы должны (ну как должны!? вообще то нам никто ничего не должен) получить равновероятный прогноз события 1 и события 0. Ниже на графике эту норму в 50% изображает серая линия. Красная это прогноз события=1, синяя событие=0, ось Х число примеров на обучающей выборке в тысячах.

И пусть девочка кинет в меня камне если тут нет сходимости.

( Читать дальше )

Блог им. afecn19 |Блеск и нищета нейросети. Part 5.

- 18 ноября 2019, 11:12

- |

Был сгенерирована табличка в 50 тысяч строк и 103 столбцов. Один столбец это даты, еще один — таргет, который мы пытаемся предсказать (событие 1 и событие 0). 101 столбец изображают фичи, из которых 100 случайные величины от 1 до 10, а одна осмысленная (Week) принимает значение от 1 до 5. Для week от 1 до 4 равновероятно событие 1 и 2, для Week = 5 вероятность события 1 = 60%, 2 = 40%.

«Шо за фигня аффтор?!». Фигня не фигня, а я моделирую свое виденье рынка и своего подхода к поиску рабочих стратегий. Виденье рынка предполагает что рынок рандомно блуждает значительную часть времени (в моему случаи 80% времени), а оставшееся его можно описать несколькими хорошими фичами. Ну как описать? Не на 100%, ну а где то процентов на 60. Сравните с детерминированным подходом ученых столетней давности — «если нам дать все фичи и много много вычислительных мощностей мы вам все посчитаем, с точностью в 100% и для любого мгновения времени!». Понятно что после этого появилось много других идей, нелинейная динамика к примеру, которая именно предполагает принципиальную невозможность прогнозирования, а не потому что нам чего то в данных недодали. Ну и наконец постановка задачи: у нас есть 101 фича, и нам с помощью инструментов ML надо получить такой прогноз события 1, который бы бился с заложенной нами неэффектиностью. И тут не помогут завывания нейросетей-что мы «фичи кривые заложили, на которых совершенно невозможно работать!», что «просто рынок изменился!, не имезнился мы бы огого!». Нам совершенно плевать на accuracy на трейне и даже на тесте. Мы как тот глупый учитель, который может не очень то и соображает зато у которого на клочке бумажки записан правильный ответ, а напротив него ученик, в очечках, но у которого почему то при всех сплетнях что он в уме может перемножить трехзначные цифры, при сложения 1+1, получается то 5, то 6 то -32. Не, конечно вариант что мальчик в очечках не так уж и не прав возможен, может он считал в невклидовых метриках к примеру, или перемножать он умеет а вот что такое складывание ему просто не сказали.

( Читать дальше )

- bitcoin

- brent

- eurusd

- forex

- gbpusd

- gold

- imoex

- nasdaq

- nyse

- rts

- s&p500

- si

- usdrub

- wti

- акции

- алготрейдинг

- анализ

- аналитика

- аэрофлот

- банки

- биржа

- биткоин

- брокеры

- валюта

- вдо

- волновой анализ

- волны эллиотта

- вопрос

- втб

- газ

- газпром

- гмк норникель

- дивиденды

- доллар

- доллар рубль

- евро

- ецб

- золото

- инвестиции

- инфляция

- китай

- коронавирус

- кризис

- криптовалюта

- лидеры роста и падения ммвб

- лукойл

- магнит

- ммвб

- мобильный пост

- мосбиржа

- московская биржа

- нефть

- новатэк

- новости

- обзор рынка

- облигации

- опек+

- опрос

- опционы

- офз

- оффтоп

- прогноз

- прогноз по акциям

- путин

- раскрытие информации

- ри

- роснефть

- россия

- ртс

- рубль

- рынки

- рынок

- санкции

- сбер

- сбербанк

- си

- сигналы

- смартлаб

- сущфакты

- сша

- технический анализ

- торговля

- торговые роботы

- торговые сигналы

- трейдер

- трейдинг

- украина

- финансы

- фондовый рынок

- форекс

- фрс

- фьючерс

- фьючерс mix

- фьючерс ртс

- фьючерсы

- цб

- шорт

- экономика

- юмор

- яндекс